找到

24

篇与

程序

相关的结果

- 第 2 页

-

苹果 CMS 影视资源接口整合与对接全攻略 | 打造丰富影视平台 头图图片 苹果CMS影视资源接口整合与对接全攻略 在影视内容平台搭建的技术领域中,苹果CMS凭借其开源免费、操作便捷等突出特性,成为众多开发者搭建影视网站的得力助手。今天,为大家精心整理了一系列实用的影视资源接口,并带来超详细的在苹果CMS中对接这些接口的教程,助力大家打造出独具特色的影视平台。 一、影视资源接口大盘点 1.红牛资源站 红牛资源站提供了多样化的接口,适配不同的使用场景和需求。 红牛资源yun xml接口:https://www.hongniuzy2.com/api.php/provide/vod/from/hnyun/at/xml/ ,通过这个接口,能够获取以特定yun资源格式组织的影视内容数据。这种格式在数据的编排和传输上有着独特优势,能够高效地为影视平台输送丰富的影视资源信息,无论是热门大片、热门剧集,还是小众的文艺作品,都能精准地呈现在平台上。 红牛资源m3u8 xml接口:https://www.hongniuzy2.com/api.php/provide/vod/from/hnm3u8/at/xml/ ,m3u8格式在视频播放领域兼容性极佳,无论是电脑端的各种浏览器,还是移动端的各类视频播放应用,都能完美适配。借助此接口,能轻松将m3u8格式的影视资源整合到自己的平台,为用户带来高清、流畅的播放体验。 备用接口系列:考虑到网络环境的复杂性和服务器可能出现的状况,红牛资源站还贴心地准备了备用接口。 红牛资源xml备用接口:https://www.hongniuzy3.com/api.php/provide/vod/at/xml/ 红牛资源yun xml备用接口:https://www.hongniuzy3.com/api.php/provide/vod/from/hnyun/at/xml/ 红牛资源m3u8 xml备用接口:https://www.hongniuzy3.com/api.php/provide/vod/from/hnm3u8/at/xml/ ,这些备用接口就像是坚固的后盾,当主接口遭遇网络波动、服务器维护等问题时,能确保数据获取的连续性,保障影视平台的稳定运行。 2.无尽资源站 无尽资源站在资源获取和播放体验方面展现出了诸多亮点。 资源站域名:拥有多个域名,包括wujinzy.com、wujinzy.net、wujinzy.co、wujinzy.cc 。多个域名的设置极大地提升了资源站的访问稳定性,当某个域名因网络故障或其他原因无法访问时,用户可以通过其他域名顺利访问资源站,避免了用户流失。同时,多个域名还能分散网络流量,减轻单个域名的访问压力,从而提升整体的访问速度,为用户带来更流畅的体验。 图片处理策略:在图片调用方面,无尽资源站采用了图床方式。这种方式能够方便地调用各种图片资源,减少了本地存储图片的负担。然而,为了防止图片在未来出现失效的情况,资源站建议在采集图片时将其同步保存到本地。这样一来,即使图床出现问题,平台上的图片依然能够正常显示,确保了平台页面的完整性和美观度,为用户提供良好的视觉体验。 采集教程支持:对于新手开发者来说,采集影视资源可能是一个颇具挑战性的任务。不过,无尽资源站提供了详细的采集教程,地址为http://help.wujinapi.me 。这份教程就像一本贴心的操作指南,从最基础的步骤开始讲解,逐步引导用户如何正确地采集影视资源。无论是采集参数的设置,还是优质资源的筛选方法,教程中都有详细的说明,即便是没有太多经验的开发者,只要按照教程的指导进行操作,也能快速上手,顺利地将无尽资源站的影视资源采集到自己的平台上。 M3U8解析接口:在播放功能方面,无尽资源站提供了强大的M3U8解析接口。 主解析接口:https://jx.wujinkk.com/dplayer/?url= 备用解析接口:https://jx.wuvodbf.com/dplayer/?url= ,这两个解析接口经过精心优化,能够确保在播放M3U8格式的影视资源时,实现流畅、稳定的播放效果。无论是高清视频还是流畅视频,都能通过这些解析接口快速加载,为用户带来绝佳的观看体验,让用户沉浸在精彩的影视世界中。 3.闪电资源站 闪电资源站在接口设置和播放解析方面有着独特之处。 播放器标识:具有明确的播放器标识sdm3u8 。这个标识就像是闪电资源站的一个独特符号,方便开发者在使用其接口时,能够快速识别并适配相应的播放器,确保影视资源能够在平台上准确无误地播放,为用户提供顺畅的播放服务。 采集接口:其采集接口为https://xsd.sdzyapi.com/api.php/provide/vod/from/sdm3u8/at/xml 。通过这个采集接口,可以获取以sdm3u8格式组织的影视资源数据。这种格式的数据在传输和处理过程中具有较高的效率和稳定性,能够为平台提供高质量的影视资源,满足用户对丰富影视内容的需求。 播放解析接口:在播放解析方面,闪电资源站不断进行优化升级。 老播放解析接口:https://www.shankubf.com/m3u8/?url= 新播放解析接口:https://www.shandianbf.com/m3u8/?url= ,新的播放解析接口在技术上进行了改进和完善,能够更好地适应不同的网络环境和用户设备,有效提升了播放的稳定性和流畅性,为用户带来更优质的播放体验,让用户能够更轻松地观看喜爱的影视节目。 4.优质资源站 优质资源站以其出色的CDN加速服务和高清的画质吸引了众多用户的关注。 域名体系:主域名是yzzy.tv ,同时还配备了多个备用网址,如hdzyk.com以及1080zyk1.com至1080zyk15.com 。这些域名的设置不仅增加了资源站的可访问性,当主域名出现访问拥堵、服务器故障等问题时,用户可以通过备用网址快速访问优质资源站,获取自己喜爱的影视资源。而且,多个域名有助于提升网站的整体性能和稳定性,为用户提供更可靠的服务。 M3U8解析服务:在M3U8解析方面,优质资源站提供了功能强大的解析接口。 主解析接口:https://vip.zykbf.com/?url= 备用解析接口:https://vip.yyzyplay.com/?url= ,这两个解析接口经过精心优化和调试,能够确保高清视频在播放时保持流畅。无论是蓝光画质的大片,还是1080P高清的电视剧集,都能通过这些解析接口快速加载,为用户呈现出清晰、逼真的影视画面,让用户仿佛身临其境,享受极致的视觉盛宴。此外,优质资源站还提醒用户要注意封面图片地址的更换,原pic3.yzzyimages.com需要替换为pic3.yzzyimg.online ,以保证封面图片能够正常显示,提升平台的整体美观度。 5.新浪资源站 新浪资源站提供了简洁而实用的M3U8视频解析接口:https://www.xinlangjiexi.com/m3u8/?url= 。虽然接口数量相对较少,但这个解析接口功能强大,能够快速、准确地对M3U8格式的视频进行解析,让用户能够在新浪资源站或者整合了该接口的平台上流畅地播放影视视频,为用户带来便捷的观看体验。6.华为吧资源站 华为吧资源站在接口设置上兼顾了不同的数据格式需求。 视频列表接口:提供了json和xml两种格式的视频列表接口。 json接口:https://cjhwba.com/api.php/provide/vod/?ac=list ,json格式的数据具有传输速度快、解析简单的特点,能够快速被程序读取和处理,方便开发者获取视频列表信息。 xml接口:https://cjhwba.com/api.php/provide/vod/at/xml/?ac=list ,xml格式的数据则具有良好的结构性和可读性,便于开发者进行数据的整理和分析,根据自己的需求提取关键信息。开发者可以根据项目的具体需求和技术特点,选择合适的接口来获取华为吧资源站的视频列表数据。 M3U8解析接口:在视频播放方面,华为吧资源站的M3U8解析接口为https://player.dphw8.com/player?url= 。这个解析接口能够高效地将M3U8格式的视频进行解析,实现流畅的视频播放。无论是在电脑浏览器上,还是在移动设备的应用程序中,都能通过这个解析接口为用户提供稳定、流畅的播放服务,让用户随时随地都能观看自己喜欢的影视内容。 7.黑木耳资源站 黑木耳资源站针对不同的服务器环境,提供了全面的采集接口解决方案。 国内服务器采集接口:对于使用国内服务器的用户,提供了专门的采集接口。 json采集接口:https://json02.heimuer.xyz/api.php/provide/vod/?ac=list xml采集接口:https://xml02.heimuer.xyz/api.php/provide/vod/at/xml/?ac=list ,这两个接口能够充分适应国内服务器的网络环境和数据传输要求,确保用户能够稳定、高效地采集到黑木耳资源站的影视资源数据,为搭建影视平台提供丰富的素材。 海外服务器采集接口:如果用户使用的是海外服务器,黑木耳资源站也有相应的适配接口。 json采集接口:https://json.heimuer.xyz/api.php/provide/vod/?ac=list xml采集接口:https://xml.heimuer.xyz/api.php/provide/vod/at/xml/?ac=list ,这些接口针对海外服务器的网络特点进行了优化,能够在不同的网络环境下实现快速、稳定的数据采集,满足海外用户搭建影视平台的需求。 M3U8解析接口:在视频播放解析方面,黑木耳资源站的M3U8解析接口是https://hoplayer.com/index.html?url= 。这个解析接口能够有效地对M3U8格式的视频进行解析,为影视播放提供有力支持,让用户能够在平台上流畅地观看黑木耳资源站的影视内容,享受精彩的影视节目。 8.ok资源站 ok资源站在加速播放和资源采集方面有着独特的优势。 P2P商业加速解接口:其P2P商业加速解接口为https://jiexi.okzyw.info/m3u8/?url= 。该接口运用先进的P2P技术,能够有效地加速视频的播放速度。在网络环境复杂、带宽有限的情况下,通过充分利用网络节点的资源,实现视频的快速加载和流畅播放,为用户带来更流畅、更舒适的观看体验,让用户不再为视频卡顿而烦恼。 xml采集接口:ok资源站的xml采集接口是https://api.okzy.org/api.php/provide/vod/from/okm3u8/at/xml 。通过这个采集接口,可以获取以okm3u8格式组织的影视资源数据。这种格式的数据在资源的整合和管理上具有一定的优势,方便开发者将ok资源站的影视资源集成到自己的平台上,丰富平台的影视内容。 播放器标识:ok资源站的播放器标识为okm3u8 ,这个标识有助于开发者在系统中准确地识别和调用与ok资源站相关的播放器,确保影视资源能够在平台上正确、流畅地播放,为用户提供稳定的播放服务。 9.鸭鸭资源站 鸭鸭资源站在接口设置和播放加速方面表现出色。 加速解析接口:鸭鸭资源站的加速解析接口是https://jx.yayazy.cc/m3u8/?url= 。该接口通过优化解析算法和网络传输策略,能够对视频播放进行有效的加速处理。无论是在网络高峰期,还是在网络信号不稳定的情况下,都能尽力保证视频的流畅播放,为用户提供更稳定、更快速的播放体验,让用户能够尽情享受影视带来的乐趣。 丰富的接口资源:鸭鸭资源站提供了丰富多样的接口。 xml接口:https://cj.yayazy.net/api.php/provide/vod/from/yym3u8/at/xml josn接口:https://cj.yayazy.net/api.php/provide/vod/?ac=list 备用接口xml:https://cj2.yayazy.net/api.php/provide/vod/from/yym3u8/at/xml 备用接口josn:https://cj2.yayazy.net/api.php/provide/vod/?ac=list ,这些丰富的接口和备用接口确保了数据获取的稳定性和可靠性。即使主接口出现问题,也能通过备用接口继续获取影视资源数据,保证平台的正常运行,为用户持续提供丰富的影视内容。 10.如意资源站 如意资源站提供了多种类型的xml接口,为影视平台的搭建提供了丰富的资源支持。 如意资源综合接口: 资源名称:如意资源综合 接口地址:https://cj.rycjapi.com/api.php/provide/vod/at/xml/ 接口类型:xml 资源类型:视频,通过这个接口,可以获取到如意资源站综合性的影视视频资源数据,涵盖了各种类型的影视内容,为影视平台丰富内容提供有力支持。 如意m3u8接口: 资源名称:如意m3u8 接口地址:https://cj.rycjapi.com/api.php/provide/vod/from/rym3u8/at/xml/ 接口类型:xml 资源类型:视频,该接口专注于m3u8格式的视频资源,方便平台整合此类格式的影视内容,以其良好的兼容性为用户带来流畅的播放体验。 如意云接口: 资源名称:如意云 接口地址:https://cj.rycjapi.com/api.php/provide/vod/from/ruyi/at/xml/ 接口类型:xml 资源类型:视频,此接口提供基于如意云的影视资源数据,凭借其独特的资源优势助力影视平台的搭建,为用户带来更多优质的影视资源选择。 11.飞飞资源站 飞飞资源站在接口设置和使用方面有其特殊之处。 播放器标识:播放器标识为ffm3u8 ,这个标识方便开发者在系统中识别和调用与飞飞资源站相关的播放器,确保影视资源能够在平台上正确播放,为用户提供准确的播放服务。 播放解析接口:播放解析接口是https://jiexi.feifeizy.info/m3u8/?url= ,通过该接口可以对视频进行解析,实现流畅播放,为用户提供观看影视资源的渠道,让用户能够顺利观看飞飞资源站的影视内容。 通用采集接口: xml接口:https://api.feifeizy.me/api.php/provide/vod/at/xml/ json接口:https://api.feifeizy.me/api.php/provide/vod/?ac=list ,利用这些采集接口,能够获取飞飞资源站的影视资源数据,用于影视平台的资源整合,丰富平台的影视库。 使用注意事项:在使用飞飞资源站的接口时,需要注意导入播放器后要在后台清空缓存,然后再进行采集,这样可以确保数据的准确获取和平台的正常运行。同时,要特别注意本资源屏蔽国内线路,使用者需根据自身网络环境合理使用。 二、苹果CMS对接详细步骤 前期准备工作 在开始对接接口之前,需要确保已经成功安装并搭建好了苹果CMS系统,并且拥有对系统文件和数据库的操作权限。同时,要仔细检查服务器环境是否满足苹果CMS的运行要求,例如PHP版本需符合规定(一般建议较高版本以确保系统性能和安全性),MySQL版本也要适配。只有在这些基础条件都满足的情况下,才能顺利进行后续的接口对接工作。 添加采集规则 登录苹果CMS系统后台,找到“采集管理”选项,然后进入“采集规则”页面。这个页面是管理采集规则的核心区域,所有关于采集的设置都在这里进行。 点击“添加采集规则”按钮,开始创建新的采集规则。这一步是对接接口的关键步骤之一,需要认真填写各项信息。 基本信息设置:首先,填写规则名称,规则名称要具有明确的标识性,方便区分不同的采集规则,比如“红牛资源站采集规则”。然后,根据接口的类型,在采集类型中选择xml或json。准确选择采集类型对于后续的数据获取至关重要。 列表规则设置:以红牛资源站yun xml接口为例,在“列表地址”处准确填写https://www.hongniuzy2.com/api.php/provide/vod/from/hnyun/at/xml/ 。接下来,需要根据接口返回的数据结构,仔细设置“列表循环规则,要设置“列表循环规则”,通常得深入分析xml标签结构。比如,经过查看接口返回的xml数据,若发现每个影视资源项都被包裹在<voditem>标签内 ,那就可以将<voditem>设置为列表循环标签。这一步的关键在于精准定位包含影视资源基本信息的标签,这样系统才能按照规则循环读取每个资源项的数据。 同时,还可能需要设置一些其他的列表相关参数,如列表分页规则。如果接口返回的数据存在分页情况,就需要明确如何从接口地址或者返回数据中获取分页信息,以便系统能够自动采集多页的资源数据。例如,有些接口可能通过在URL中添加页码参数来实现分页,如https://www.example.com/api?page=1,https://www.example.com/api?page=2等,这时就需要设置好如何修改这个页码参数来实现翻页采集。 内容规则设置 设置内容规则的目的是明确如何从每个资源项中提取出影视资源的详细信息,像名称、描述、播放地址等关键数据。这同样需要依据xml结构来操作。 假设影视名称在<name>标签内,那么在内容规则的“名称”对应设置处,填写<name>标签路径(具体根据实际xml层级结构确定,可能是/voditem/name这样的完整路径)。对于影视描述,若在<description>标签内,也按类似方式设置。 而播放地址的设置更为关键,因为这直接关系到用户能否正常播放视频。若播放地址在<playurl>标签内,要准确设置好该标签路径。有时,播放地址可能不是直接的视频链接,而是需要经过进一步解析的地址,这种情况下就需要研究如何对该地址进行二次处理以获取真实的播放链接。 保存设置 当完成上述各项设置后,务必仔细检查一遍,确保所有信息准确无误。确认无误后,点击“保存”按钮,这样采集规则就成功保存下来了。之后系统就会按照这个规则去采集相应接口的影视资源数据。 3. 添加播放解析 进入苹果CMS系统后台的“系统设置”,找到“播放设置”页面。这里是管理视频播放相关设置的地方,包括播放解析规则等重要内容。 在“自定义解析”区域,添加新的解析规则。以新浪资源站的M3U8视频解析接口https://www.xinlangjiexi.com/m3u8/?url=为例,在“解析名称”处填写一个能清晰标识该解析规则的名称,如“新浪资源解析”。“解析地址”则填写上述真实的接口地址https://www.xinlangjiexi.com/m3u8/?url=。 同时,还需要根据解析接口的特点设置好解析类型等相关参数。不同的解析接口可能有不同的参数要求,比如有些解析接口可能需要设置超时时间、请求头信息等。这些参数的正确设置能够保证解析过程的顺利进行,确保视频能够被正确解析并播放。完成所有设置后,点击保存,使系统能够正确调用该解析接口来播放影视资源。 4. 采集与测试 返回“采集管理” - “采集规则”页面,找到刚刚创建的采集规则,点击“开始采集”按钮。此时,系统会按照设定的规则,从对应的接口获取影视资源数据,并将这些数据保存到本地数据库中。采集过程可能需要一些时间,具体取决于接口返回数据量的大小以及网络状况。 采集完成后,到前台页面浏览影视资源列表。点击列表中的影视资源进行播放测试。如果播放正常,视频能够流畅加载并播放,那就说明接口对接成功了。但如果出现问题,比如页面提示播放错误、视频无法加载等情况,就需要逐步排查问题。首先检查采集规则是否设置正确,特别是列表规则和内容规则中关于数据提取的设置是否准确。其次,检查播放解析设置是否正确,包括解析地址、解析类型以及相关参数。最后,还需要确认接口本身是否正常,可以通过在浏览器中直接访问接口地址,查看返回的数据是否符合预期来判断。若接口本身存在问题,可能需要联系接口提供方解决。 通过以上详细且全面的步骤,你就可以将这些影视资源接口与苹果CMS系统成功对接,搭建出一个拥有丰富影视内容的平台。但在后续使用过程中,要时刻关注各资源站的公告信息,因为接口可能会因为各种原因进行调整或更新。一旦接口有变化,需要及时相应地修改采集规则和播放解析设置,以确保平台始终能够稳定运行,为用户持续提供优质的影视服务。

苹果 CMS 影视资源接口整合与对接全攻略 | 打造丰富影视平台 头图图片 苹果CMS影视资源接口整合与对接全攻略 在影视内容平台搭建的技术领域中,苹果CMS凭借其开源免费、操作便捷等突出特性,成为众多开发者搭建影视网站的得力助手。今天,为大家精心整理了一系列实用的影视资源接口,并带来超详细的在苹果CMS中对接这些接口的教程,助力大家打造出独具特色的影视平台。 一、影视资源接口大盘点 1.红牛资源站 红牛资源站提供了多样化的接口,适配不同的使用场景和需求。 红牛资源yun xml接口:https://www.hongniuzy2.com/api.php/provide/vod/from/hnyun/at/xml/ ,通过这个接口,能够获取以特定yun资源格式组织的影视内容数据。这种格式在数据的编排和传输上有着独特优势,能够高效地为影视平台输送丰富的影视资源信息,无论是热门大片、热门剧集,还是小众的文艺作品,都能精准地呈现在平台上。 红牛资源m3u8 xml接口:https://www.hongniuzy2.com/api.php/provide/vod/from/hnm3u8/at/xml/ ,m3u8格式在视频播放领域兼容性极佳,无论是电脑端的各种浏览器,还是移动端的各类视频播放应用,都能完美适配。借助此接口,能轻松将m3u8格式的影视资源整合到自己的平台,为用户带来高清、流畅的播放体验。 备用接口系列:考虑到网络环境的复杂性和服务器可能出现的状况,红牛资源站还贴心地准备了备用接口。 红牛资源xml备用接口:https://www.hongniuzy3.com/api.php/provide/vod/at/xml/ 红牛资源yun xml备用接口:https://www.hongniuzy3.com/api.php/provide/vod/from/hnyun/at/xml/ 红牛资源m3u8 xml备用接口:https://www.hongniuzy3.com/api.php/provide/vod/from/hnm3u8/at/xml/ ,这些备用接口就像是坚固的后盾,当主接口遭遇网络波动、服务器维护等问题时,能确保数据获取的连续性,保障影视平台的稳定运行。 2.无尽资源站 无尽资源站在资源获取和播放体验方面展现出了诸多亮点。 资源站域名:拥有多个域名,包括wujinzy.com、wujinzy.net、wujinzy.co、wujinzy.cc 。多个域名的设置极大地提升了资源站的访问稳定性,当某个域名因网络故障或其他原因无法访问时,用户可以通过其他域名顺利访问资源站,避免了用户流失。同时,多个域名还能分散网络流量,减轻单个域名的访问压力,从而提升整体的访问速度,为用户带来更流畅的体验。 图片处理策略:在图片调用方面,无尽资源站采用了图床方式。这种方式能够方便地调用各种图片资源,减少了本地存储图片的负担。然而,为了防止图片在未来出现失效的情况,资源站建议在采集图片时将其同步保存到本地。这样一来,即使图床出现问题,平台上的图片依然能够正常显示,确保了平台页面的完整性和美观度,为用户提供良好的视觉体验。 采集教程支持:对于新手开发者来说,采集影视资源可能是一个颇具挑战性的任务。不过,无尽资源站提供了详细的采集教程,地址为http://help.wujinapi.me 。这份教程就像一本贴心的操作指南,从最基础的步骤开始讲解,逐步引导用户如何正确地采集影视资源。无论是采集参数的设置,还是优质资源的筛选方法,教程中都有详细的说明,即便是没有太多经验的开发者,只要按照教程的指导进行操作,也能快速上手,顺利地将无尽资源站的影视资源采集到自己的平台上。 M3U8解析接口:在播放功能方面,无尽资源站提供了强大的M3U8解析接口。 主解析接口:https://jx.wujinkk.com/dplayer/?url= 备用解析接口:https://jx.wuvodbf.com/dplayer/?url= ,这两个解析接口经过精心优化,能够确保在播放M3U8格式的影视资源时,实现流畅、稳定的播放效果。无论是高清视频还是流畅视频,都能通过这些解析接口快速加载,为用户带来绝佳的观看体验,让用户沉浸在精彩的影视世界中。 3.闪电资源站 闪电资源站在接口设置和播放解析方面有着独特之处。 播放器标识:具有明确的播放器标识sdm3u8 。这个标识就像是闪电资源站的一个独特符号,方便开发者在使用其接口时,能够快速识别并适配相应的播放器,确保影视资源能够在平台上准确无误地播放,为用户提供顺畅的播放服务。 采集接口:其采集接口为https://xsd.sdzyapi.com/api.php/provide/vod/from/sdm3u8/at/xml 。通过这个采集接口,可以获取以sdm3u8格式组织的影视资源数据。这种格式的数据在传输和处理过程中具有较高的效率和稳定性,能够为平台提供高质量的影视资源,满足用户对丰富影视内容的需求。 播放解析接口:在播放解析方面,闪电资源站不断进行优化升级。 老播放解析接口:https://www.shankubf.com/m3u8/?url= 新播放解析接口:https://www.shandianbf.com/m3u8/?url= ,新的播放解析接口在技术上进行了改进和完善,能够更好地适应不同的网络环境和用户设备,有效提升了播放的稳定性和流畅性,为用户带来更优质的播放体验,让用户能够更轻松地观看喜爱的影视节目。 4.优质资源站 优质资源站以其出色的CDN加速服务和高清的画质吸引了众多用户的关注。 域名体系:主域名是yzzy.tv ,同时还配备了多个备用网址,如hdzyk.com以及1080zyk1.com至1080zyk15.com 。这些域名的设置不仅增加了资源站的可访问性,当主域名出现访问拥堵、服务器故障等问题时,用户可以通过备用网址快速访问优质资源站,获取自己喜爱的影视资源。而且,多个域名有助于提升网站的整体性能和稳定性,为用户提供更可靠的服务。 M3U8解析服务:在M3U8解析方面,优质资源站提供了功能强大的解析接口。 主解析接口:https://vip.zykbf.com/?url= 备用解析接口:https://vip.yyzyplay.com/?url= ,这两个解析接口经过精心优化和调试,能够确保高清视频在播放时保持流畅。无论是蓝光画质的大片,还是1080P高清的电视剧集,都能通过这些解析接口快速加载,为用户呈现出清晰、逼真的影视画面,让用户仿佛身临其境,享受极致的视觉盛宴。此外,优质资源站还提醒用户要注意封面图片地址的更换,原pic3.yzzyimages.com需要替换为pic3.yzzyimg.online ,以保证封面图片能够正常显示,提升平台的整体美观度。 5.新浪资源站 新浪资源站提供了简洁而实用的M3U8视频解析接口:https://www.xinlangjiexi.com/m3u8/?url= 。虽然接口数量相对较少,但这个解析接口功能强大,能够快速、准确地对M3U8格式的视频进行解析,让用户能够在新浪资源站或者整合了该接口的平台上流畅地播放影视视频,为用户带来便捷的观看体验。6.华为吧资源站 华为吧资源站在接口设置上兼顾了不同的数据格式需求。 视频列表接口:提供了json和xml两种格式的视频列表接口。 json接口:https://cjhwba.com/api.php/provide/vod/?ac=list ,json格式的数据具有传输速度快、解析简单的特点,能够快速被程序读取和处理,方便开发者获取视频列表信息。 xml接口:https://cjhwba.com/api.php/provide/vod/at/xml/?ac=list ,xml格式的数据则具有良好的结构性和可读性,便于开发者进行数据的整理和分析,根据自己的需求提取关键信息。开发者可以根据项目的具体需求和技术特点,选择合适的接口来获取华为吧资源站的视频列表数据。 M3U8解析接口:在视频播放方面,华为吧资源站的M3U8解析接口为https://player.dphw8.com/player?url= 。这个解析接口能够高效地将M3U8格式的视频进行解析,实现流畅的视频播放。无论是在电脑浏览器上,还是在移动设备的应用程序中,都能通过这个解析接口为用户提供稳定、流畅的播放服务,让用户随时随地都能观看自己喜欢的影视内容。 7.黑木耳资源站 黑木耳资源站针对不同的服务器环境,提供了全面的采集接口解决方案。 国内服务器采集接口:对于使用国内服务器的用户,提供了专门的采集接口。 json采集接口:https://json02.heimuer.xyz/api.php/provide/vod/?ac=list xml采集接口:https://xml02.heimuer.xyz/api.php/provide/vod/at/xml/?ac=list ,这两个接口能够充分适应国内服务器的网络环境和数据传输要求,确保用户能够稳定、高效地采集到黑木耳资源站的影视资源数据,为搭建影视平台提供丰富的素材。 海外服务器采集接口:如果用户使用的是海外服务器,黑木耳资源站也有相应的适配接口。 json采集接口:https://json.heimuer.xyz/api.php/provide/vod/?ac=list xml采集接口:https://xml.heimuer.xyz/api.php/provide/vod/at/xml/?ac=list ,这些接口针对海外服务器的网络特点进行了优化,能够在不同的网络环境下实现快速、稳定的数据采集,满足海外用户搭建影视平台的需求。 M3U8解析接口:在视频播放解析方面,黑木耳资源站的M3U8解析接口是https://hoplayer.com/index.html?url= 。这个解析接口能够有效地对M3U8格式的视频进行解析,为影视播放提供有力支持,让用户能够在平台上流畅地观看黑木耳资源站的影视内容,享受精彩的影视节目。 8.ok资源站 ok资源站在加速播放和资源采集方面有着独特的优势。 P2P商业加速解接口:其P2P商业加速解接口为https://jiexi.okzyw.info/m3u8/?url= 。该接口运用先进的P2P技术,能够有效地加速视频的播放速度。在网络环境复杂、带宽有限的情况下,通过充分利用网络节点的资源,实现视频的快速加载和流畅播放,为用户带来更流畅、更舒适的观看体验,让用户不再为视频卡顿而烦恼。 xml采集接口:ok资源站的xml采集接口是https://api.okzy.org/api.php/provide/vod/from/okm3u8/at/xml 。通过这个采集接口,可以获取以okm3u8格式组织的影视资源数据。这种格式的数据在资源的整合和管理上具有一定的优势,方便开发者将ok资源站的影视资源集成到自己的平台上,丰富平台的影视内容。 播放器标识:ok资源站的播放器标识为okm3u8 ,这个标识有助于开发者在系统中准确地识别和调用与ok资源站相关的播放器,确保影视资源能够在平台上正确、流畅地播放,为用户提供稳定的播放服务。 9.鸭鸭资源站 鸭鸭资源站在接口设置和播放加速方面表现出色。 加速解析接口:鸭鸭资源站的加速解析接口是https://jx.yayazy.cc/m3u8/?url= 。该接口通过优化解析算法和网络传输策略,能够对视频播放进行有效的加速处理。无论是在网络高峰期,还是在网络信号不稳定的情况下,都能尽力保证视频的流畅播放,为用户提供更稳定、更快速的播放体验,让用户能够尽情享受影视带来的乐趣。 丰富的接口资源:鸭鸭资源站提供了丰富多样的接口。 xml接口:https://cj.yayazy.net/api.php/provide/vod/from/yym3u8/at/xml josn接口:https://cj.yayazy.net/api.php/provide/vod/?ac=list 备用接口xml:https://cj2.yayazy.net/api.php/provide/vod/from/yym3u8/at/xml 备用接口josn:https://cj2.yayazy.net/api.php/provide/vod/?ac=list ,这些丰富的接口和备用接口确保了数据获取的稳定性和可靠性。即使主接口出现问题,也能通过备用接口继续获取影视资源数据,保证平台的正常运行,为用户持续提供丰富的影视内容。 10.如意资源站 如意资源站提供了多种类型的xml接口,为影视平台的搭建提供了丰富的资源支持。 如意资源综合接口: 资源名称:如意资源综合 接口地址:https://cj.rycjapi.com/api.php/provide/vod/at/xml/ 接口类型:xml 资源类型:视频,通过这个接口,可以获取到如意资源站综合性的影视视频资源数据,涵盖了各种类型的影视内容,为影视平台丰富内容提供有力支持。 如意m3u8接口: 资源名称:如意m3u8 接口地址:https://cj.rycjapi.com/api.php/provide/vod/from/rym3u8/at/xml/ 接口类型:xml 资源类型:视频,该接口专注于m3u8格式的视频资源,方便平台整合此类格式的影视内容,以其良好的兼容性为用户带来流畅的播放体验。 如意云接口: 资源名称:如意云 接口地址:https://cj.rycjapi.com/api.php/provide/vod/from/ruyi/at/xml/ 接口类型:xml 资源类型:视频,此接口提供基于如意云的影视资源数据,凭借其独特的资源优势助力影视平台的搭建,为用户带来更多优质的影视资源选择。 11.飞飞资源站 飞飞资源站在接口设置和使用方面有其特殊之处。 播放器标识:播放器标识为ffm3u8 ,这个标识方便开发者在系统中识别和调用与飞飞资源站相关的播放器,确保影视资源能够在平台上正确播放,为用户提供准确的播放服务。 播放解析接口:播放解析接口是https://jiexi.feifeizy.info/m3u8/?url= ,通过该接口可以对视频进行解析,实现流畅播放,为用户提供观看影视资源的渠道,让用户能够顺利观看飞飞资源站的影视内容。 通用采集接口: xml接口:https://api.feifeizy.me/api.php/provide/vod/at/xml/ json接口:https://api.feifeizy.me/api.php/provide/vod/?ac=list ,利用这些采集接口,能够获取飞飞资源站的影视资源数据,用于影视平台的资源整合,丰富平台的影视库。 使用注意事项:在使用飞飞资源站的接口时,需要注意导入播放器后要在后台清空缓存,然后再进行采集,这样可以确保数据的准确获取和平台的正常运行。同时,要特别注意本资源屏蔽国内线路,使用者需根据自身网络环境合理使用。 二、苹果CMS对接详细步骤 前期准备工作 在开始对接接口之前,需要确保已经成功安装并搭建好了苹果CMS系统,并且拥有对系统文件和数据库的操作权限。同时,要仔细检查服务器环境是否满足苹果CMS的运行要求,例如PHP版本需符合规定(一般建议较高版本以确保系统性能和安全性),MySQL版本也要适配。只有在这些基础条件都满足的情况下,才能顺利进行后续的接口对接工作。 添加采集规则 登录苹果CMS系统后台,找到“采集管理”选项,然后进入“采集规则”页面。这个页面是管理采集规则的核心区域,所有关于采集的设置都在这里进行。 点击“添加采集规则”按钮,开始创建新的采集规则。这一步是对接接口的关键步骤之一,需要认真填写各项信息。 基本信息设置:首先,填写规则名称,规则名称要具有明确的标识性,方便区分不同的采集规则,比如“红牛资源站采集规则”。然后,根据接口的类型,在采集类型中选择xml或json。准确选择采集类型对于后续的数据获取至关重要。 列表规则设置:以红牛资源站yun xml接口为例,在“列表地址”处准确填写https://www.hongniuzy2.com/api.php/provide/vod/from/hnyun/at/xml/ 。接下来,需要根据接口返回的数据结构,仔细设置“列表循环规则,要设置“列表循环规则”,通常得深入分析xml标签结构。比如,经过查看接口返回的xml数据,若发现每个影视资源项都被包裹在<voditem>标签内 ,那就可以将<voditem>设置为列表循环标签。这一步的关键在于精准定位包含影视资源基本信息的标签,这样系统才能按照规则循环读取每个资源项的数据。 同时,还可能需要设置一些其他的列表相关参数,如列表分页规则。如果接口返回的数据存在分页情况,就需要明确如何从接口地址或者返回数据中获取分页信息,以便系统能够自动采集多页的资源数据。例如,有些接口可能通过在URL中添加页码参数来实现分页,如https://www.example.com/api?page=1,https://www.example.com/api?page=2等,这时就需要设置好如何修改这个页码参数来实现翻页采集。 内容规则设置 设置内容规则的目的是明确如何从每个资源项中提取出影视资源的详细信息,像名称、描述、播放地址等关键数据。这同样需要依据xml结构来操作。 假设影视名称在<name>标签内,那么在内容规则的“名称”对应设置处,填写<name>标签路径(具体根据实际xml层级结构确定,可能是/voditem/name这样的完整路径)。对于影视描述,若在<description>标签内,也按类似方式设置。 而播放地址的设置更为关键,因为这直接关系到用户能否正常播放视频。若播放地址在<playurl>标签内,要准确设置好该标签路径。有时,播放地址可能不是直接的视频链接,而是需要经过进一步解析的地址,这种情况下就需要研究如何对该地址进行二次处理以获取真实的播放链接。 保存设置 当完成上述各项设置后,务必仔细检查一遍,确保所有信息准确无误。确认无误后,点击“保存”按钮,这样采集规则就成功保存下来了。之后系统就会按照这个规则去采集相应接口的影视资源数据。 3. 添加播放解析 进入苹果CMS系统后台的“系统设置”,找到“播放设置”页面。这里是管理视频播放相关设置的地方,包括播放解析规则等重要内容。 在“自定义解析”区域,添加新的解析规则。以新浪资源站的M3U8视频解析接口https://www.xinlangjiexi.com/m3u8/?url=为例,在“解析名称”处填写一个能清晰标识该解析规则的名称,如“新浪资源解析”。“解析地址”则填写上述真实的接口地址https://www.xinlangjiexi.com/m3u8/?url=。 同时,还需要根据解析接口的特点设置好解析类型等相关参数。不同的解析接口可能有不同的参数要求,比如有些解析接口可能需要设置超时时间、请求头信息等。这些参数的正确设置能够保证解析过程的顺利进行,确保视频能够被正确解析并播放。完成所有设置后,点击保存,使系统能够正确调用该解析接口来播放影视资源。 4. 采集与测试 返回“采集管理” - “采集规则”页面,找到刚刚创建的采集规则,点击“开始采集”按钮。此时,系统会按照设定的规则,从对应的接口获取影视资源数据,并将这些数据保存到本地数据库中。采集过程可能需要一些时间,具体取决于接口返回数据量的大小以及网络状况。 采集完成后,到前台页面浏览影视资源列表。点击列表中的影视资源进行播放测试。如果播放正常,视频能够流畅加载并播放,那就说明接口对接成功了。但如果出现问题,比如页面提示播放错误、视频无法加载等情况,就需要逐步排查问题。首先检查采集规则是否设置正确,特别是列表规则和内容规则中关于数据提取的设置是否准确。其次,检查播放解析设置是否正确,包括解析地址、解析类型以及相关参数。最后,还需要确认接口本身是否正常,可以通过在浏览器中直接访问接口地址,查看返回的数据是否符合预期来判断。若接口本身存在问题,可能需要联系接口提供方解决。 通过以上详细且全面的步骤,你就可以将这些影视资源接口与苹果CMS系统成功对接,搭建出一个拥有丰富影视内容的平台。但在后续使用过程中,要时刻关注各资源站的公告信息,因为接口可能会因为各种原因进行调整或更新。一旦接口有变化,需要及时相应地修改采集规则和播放解析设置,以确保平台始终能够稳定运行,为用户持续提供优质的影视服务。 -

网站 SEO 优化全攻略:掌握不同程序的优化技巧 图片 网站SEO优化全攻略:掌握不同程序的优化技巧 在数字化浪潮迅猛发展的当下,拥有一个网站仅仅是踏上网络征程的第一步。然而,如何让网站在海量的互联网信息中脱颖而出,在搜索引擎的结果页面占据优势地位,进而获取源源不断的流量和广泛的曝光,这才是众多网站运营者最为关注的核心目标。而SEO(搜索引擎优化),无疑是实现这一目标的关键手段。对于采用php+html+css+js技术开发的网站而言,由于程序类型的不同,在SEO优化实践中各有其独特的侧重点和方法。接下来,我们将深入且细致地为大家讲解常用开源程序、自主编写程序以及不开源程序的SEO优化技巧,助力你打造一个深受搜索引擎青睐的优质网站。 一、常用开源程序的SEO优化 (一)WordPress 选择合适的主题 一个设计简洁、代码规范且具备良好响应式特性的主题,是网站SEO优化的重要基础。它就像网站的门面,不仅能极大提升用户访问网站时的体验,让用户在浏览过程中感受到便捷与舒适,还能为搜索引擎的抓取工作提供便利,使搜索引擎能够更顺畅地理解和解析网站内容。以Astra主题为例,它在众多WordPress主题中表现出色,是一款备受赞誉的轻量级主题,在SEO性能方面尤为突出。其设计风格简洁大方,页面布局合理,加载速度极快,同时还支持多种布局模式和丰富的自定义选项,给予网站运营者充足的创作空间。在挑选主题时,一定要保持谨慎,远离那些设计过于复杂、代码冗余的主题,因为这类主题很可能成为网站加载速度的阻碍,进而影响搜索引擎的抓取效率,对网站的SEO排名产生不利影响。 安装SEO插件 Yoast SEO插件在WordPress的插件体系中,是SEO优化领域的重要工具,也是最为常用且功能强大的插件之一。当你成功安装并启用Yoast SEO插件后,首先要在插件的设置界面中,认真填写准确的网站信息,包括网站名称、简洁而精准的描述等关键内容。这些信息将成为搜索引擎认识和了解你网站的重要依据。在日常编辑文章时,Yoast SEO插件会成为你的优化助手,为你提供详细且实用的优化建议。它会根据你预先设定的关键词,对文章的可读性、关键词的分布密度等重要指标进行评估和提示。例如,它会通过直观的颜色标识和进度条展示,让你清晰地了解文章的优化状态,绿色表示文章在该方面优化效果良好,而红色则意味着需要你进一步调整和改进相关内容。此外,Yoast SEO插件还支持设置焦点关键词,帮助你在创作内容时能够紧密围绕关键词展开,确保文章主题明确、突出,从而更符合搜索引擎的算法规则。Yoast SEO插件官网:https://yoast.com/wordpress/plugins/seo/ 。 优化永久链接结构 构建合理的永久链接结构,对于搜索引擎准确识别页面内容至关重要。在WordPress后台的“设置 - 永久链接”选项中,强烈建议选择“文章名称”这一形式的链接结构。例如,若有一篇主题为“SEO优化基础”的文章,其链接可能呈现为“https://www.fulicode.cn/archives/189/” 。这样的链接清晰明了,直接包含了文章的核心关键词,使搜索引擎在抓取和索引页面时,能够迅速理解页面的主题和重点。此外,在链接的书写过程中,要恰当使用连字符“-”来分隔单词,避免使用下划线“_”。这是因为在搜索引擎的算法逻辑中,更倾向于识别由连字符分隔的单词,认为这样的链接结构更具语义性和可读性。 (二)Drupal 启用SEO相关模块 Drupal拥有丰富多样的模块生态系统,在这些众多的模块中,Metatag模块对于网站的SEO优化起着关键作用。一旦成功启用该模块,在内容编辑页面,你便可以便捷地自定义页面的元数据,其中包括元标题、元描述、元关键词等核心要素。这些精心设置的元数据,就像网站在搜索引擎中的“名片”,会直接影响搜索引擎对页面的展示方式以及在搜索结果中的排名位置。例如,一个精准且富有吸引力的元标题,能够在众多搜索结果中迅速吸引用户的注意力,大幅提高用户的点击率;而详细、准确的元描述,则能让用户在尚未点击进入页面之前,就对页面的大致内容有清晰的了解,从而增加用户点击的意愿。在设置元数据时,一定要注意关键词的合理分布,坚决杜绝关键词堆砌的现象,要让元数据自然流畅地融入页面信息中,符合搜索引擎的优化规则和用户的阅读习惯。 优化URL Drupal默认生成的URL往往较为复杂冗长,这种复杂的URL结构既不利于搜索引擎高效抓取页面内容,也给用户的记忆和分享带来不便。不过,借助Pathauto模块,你可以轻松实现URL的优化,自动生成简洁明了、富有语义的URL。在Pathauto模块的设置界面中,你可以根据网站内容的不同类型和分类等具体情况,灵活设置个性化的URL模式。比如,对于新闻类的内容,你可以将URL模式设置为“/news/[node:title - alias]” 。通过这样的设置,生成的URL不仅简洁美观,而且能够准确反映内容的主题和类别,更符合搜索引擎的喜好和用户的使用习惯。同时,需要特别注意的是,URL的长度不宜过长,一般建议尽量控制在100个字符以内。过长的URL可能会让搜索引擎在抓取和处理时遇到困难,也可能会降低用户在浏览和分享过程中的体验。Pathauto模块官网:https://www.drupal.org/project/pathauto 。 (三)Joomla 优化网站结构 确保网站具备清晰、合理的层次结构,是保障搜索引擎爬虫能够顺利抓取网站内容的关键前提。你可以通过合理设置菜单、分类等方式,对网站的内容进行科学、合理的组织和规划。例如,将网站的内容按照不同的主题划分为多个板块,在每个板块之下,再进一步细分具体的文章类别或者产品分类等。这样的结构布局,就像为用户和搜索引擎绘制了一张清晰的地图,使他们能够迅速、准确地找到自己所需的信息。在设置菜单时,要遵循简洁明了的原则,使用通俗易懂、能够准确概括内容的菜单名称,坚决避免使用那些模糊不清、生僻晦涩的词汇。同时,要对菜单的链接进行严格检查和测试,确保每个链接都能正常跳转,杜绝出现死链接的情况。因为死链接不仅会影响用户的浏览体验,还可能导致搜索引擎对网站的评价降低,进而影响网站的SEO排名。 安装SEO插件 JoomSEF是Joomla中一款广受欢迎且功能强大的SEO插件,它能够为你的网站URL优化工作提供全面支持,使其更符合搜索引擎的优化标准。在成功安装JoomSEF插件后,通过插件的设置界面,你可以轻松将动态URL转换为静态或伪静态URL。同时,该插件还提供了丰富的功能选项,让你能够方便地设置页面的元数据等重要信息。例如,原本像“index.php?option=com_content&view=article&id=123”这样复杂的动态URL,经过JoomSEF插件的优化处理后,可以转换为简洁且利于SEO的“/article/seo - optimization - tips”这样的静态URL。这种优化后的URL不仅能显著提高搜索引擎的抓取效率,还更方便用户记忆和分享。JoomSEF插件官网:https://www.joomsef.com/ 。 二、自己写的程序的优化 优化代码结构 确保代码简洁、规范,是提升网站性能和SEO效果的重要基础。在实际开发过程中,要尽可能避免出现冗余代码。例如,合理运用CSS和JavaScript的压缩工具,能够有效减少文件的大小,从而显著加快页面的加载速度。以UglifyJS工具为例,它可以对JavaScript代码进行深度压缩,去除代码中不必要的空格、注释以及冗余的代码片段,在不影响代码功能的前提下,极大地精简代码体积。同时,在编写HTML代码时,要充分运用语义化的HTML标签,如、、、等。这些语义化标签具有明确的语义和功能定义,能够让搜索引擎更准确地理解页面的结构和内容。例如,使用标签来定义页面的头部区域,搜索引擎就能迅速识别出该区域的功能和作用,从而在抓取和索引页面时,能够更精准地把握页面的关键信息。UglifyJS官网:https://github.com/mishoo/UglifyJS 。 设置合理的标题和元描述 在每个页面的 < head > 标签中,精心设置准确、富有吸引力的标题(< title >标签)和元描述(标签)至关重要。标题作为页面在搜索引擎结果页面中展示的重要信息,一定要包含核心关键词,并且要注意长度适中,一般建议控制在60个字符左右。例如,“最佳SEO优化教程 - 提升网站排名的实用技巧”这样的标题,既精准涵盖了“SEO优化”这一核心关键词,又通过富有吸引力的表述方式,激发了用户的点击欲望。而元描述则需要简洁明了地概括页面的主要内容,同时要具备一定的吸引力,以吸引用户点击进入页面。元描述的长度通常建议在150 - 160个字符之间。例如,“本教程详细介绍了SEO优化的各个方面,从基础概念到高级技巧,全方位帮助你提升网站在搜索引擎中的排名,获取更多的流量和曝光机会。”这样的元描述,既能让用户快速了解页面的核心内容,又能有效地引导用户点击进入页面进行深入阅读。 优化图片 对于网页中不可或缺的图片元素,进行优化处理是提升网站性能和SEO效果的重要环节。首先,要对图片的大小进行压缩处理,在尽可能降低文件体积的同时,确保图片的清晰度不受明显影响。你可以借助在线图片压缩工具,如TinyPNG(官网:https://tinypng.com/ ),或者专业的图形编辑软件,如Adobe Photoshop等,来完成图片的压缩工作。其次,为图片添加alt属性是必不可少的步骤。alt属性的作用是对图片的内容进行描述,当图片由于各种原因无法正常显示时,用户和搜索引擎可以通过alt属性的内容了解图片的大致信息。例如,对于一张展示SEO优化技巧的图片,alt属性可以设置为“SEO优化技巧图示”。这样,无论是用户还是搜索引擎,在遇到图片无法显示的情况时,都能通过alt属性获取到图片所传达的关键信息,从而保证了页面内容的完整性和可理解性。 创建XML网站地图 XML网站地图是一种能够帮助搜索引擎更好地抓取网站内容的重要工具。如果你使用的是WordPress网站,借助Yoast SEO插件(官网:https://yoast.com/wordpress/plugins/seo/ )就可以轻松生成XML网站地图。当然,你也可以选择自行编写代码来生成。在XML网站地图中,要全面、准确地列出网站的所有重要页面,包括文章页面、分类页面、产品页面等。完成网站地图的创建后,需要将其提交给各大搜索引擎,如百度站长平台(官网:https://ziyuan.baidu.com/ )、谷歌Search Console(官网:https://search.google.com/search - console )等。通过提交网站地图,搜索引擎能够及时、全面地发现和抓取网站的新内容,从而确保网站的页面能够在搜索引擎中得到及时的收录和更新,提高网站在搜索结果中的曝光率。 三、不开源程序的优化 分析现有代码 尽管面对不开源程序,我们无法直接对其代码进行修改,但我们可以对其现有代码进行深入细致的分析,从而了解其内部结构和运行机制。通过仔细查看页面的HTML、CSS和JavaScript代码,我们能够找出可能存在的影响SEO的因素。例如,是否存在大量的内联样式,这些内联样式可能会导致页面代码变得冗长繁杂,增加页面的加载时间;或者是否存在未经过优化的JavaScript代码,这些代码可能会占用过多的系统资源,影响页面的性能。如果发现页面中有大量的内联CSS样式,我们可以考虑与相关技术人员沟通,尝试将这些样式提取到外部CSS文件中,以优化页面代码结构,提高页面的加载速度和性能。 与开发者沟通 如果条件允许,积极与不开源程序的开发者进行沟通交流,是实现网站SEO优化的有效途径之一。在沟通时,要清晰、明确地向开发者阐述你的SEO优化需求。例如,你可以向开发者提出将动态URL修改为更有利于SEO的静态URL的请求,因为静态URL在搜索引擎的抓取和排名算法中往往具有更高的优先级。同时,你还可以请求开发者在页面中添加合适的元数据,如准确的页面标题、详细的元描述等,这些元数据对于提升页面在搜索引擎结果页面中的展示效果和点击率具有重要作用。开发者凭借其专业的技术知识和对程序的深入了解,可能会根据你的合理需求,对程序进行相应的调整和优化,从而为网站的SEO优化工作提供有力的支持。 利用第三方工具辅助优化 借助功能强大的第三方工具,能够有效地辅助提升不开源程序网站的SEO性能。以GTmetrix(官网:https://gtmetrix.com/ )为例,它是一款专业的网站性能分析工具,通过对网站的加载速度、页面性能等多个方面进行全面、深入的分析,为你提供详细的优化建议。你可以根据这些建议,采取针对性的优化措施,如优化图片质量和大小、压缩CSS和JavaScript文件、启用浏览器缓存等,从而显著提高网站的加载速度和用户体验。同时,百度站长平台(官网:https://ziyuan.baidu.com/ )和谷歌Search Console(官网:https://search.google.com/search - console )等工具也是不可或缺的。通过这些工具,你可以实时监测网站的收录情况、关键词排名等重要数据,及时发现网站在SEO方面存在的问题,并根据数据反馈进行相应的调整和优化,确保网站始终保持良好的SEO状态。

网站 SEO 优化全攻略:掌握不同程序的优化技巧 图片 网站SEO优化全攻略:掌握不同程序的优化技巧 在数字化浪潮迅猛发展的当下,拥有一个网站仅仅是踏上网络征程的第一步。然而,如何让网站在海量的互联网信息中脱颖而出,在搜索引擎的结果页面占据优势地位,进而获取源源不断的流量和广泛的曝光,这才是众多网站运营者最为关注的核心目标。而SEO(搜索引擎优化),无疑是实现这一目标的关键手段。对于采用php+html+css+js技术开发的网站而言,由于程序类型的不同,在SEO优化实践中各有其独特的侧重点和方法。接下来,我们将深入且细致地为大家讲解常用开源程序、自主编写程序以及不开源程序的SEO优化技巧,助力你打造一个深受搜索引擎青睐的优质网站。 一、常用开源程序的SEO优化 (一)WordPress 选择合适的主题 一个设计简洁、代码规范且具备良好响应式特性的主题,是网站SEO优化的重要基础。它就像网站的门面,不仅能极大提升用户访问网站时的体验,让用户在浏览过程中感受到便捷与舒适,还能为搜索引擎的抓取工作提供便利,使搜索引擎能够更顺畅地理解和解析网站内容。以Astra主题为例,它在众多WordPress主题中表现出色,是一款备受赞誉的轻量级主题,在SEO性能方面尤为突出。其设计风格简洁大方,页面布局合理,加载速度极快,同时还支持多种布局模式和丰富的自定义选项,给予网站运营者充足的创作空间。在挑选主题时,一定要保持谨慎,远离那些设计过于复杂、代码冗余的主题,因为这类主题很可能成为网站加载速度的阻碍,进而影响搜索引擎的抓取效率,对网站的SEO排名产生不利影响。 安装SEO插件 Yoast SEO插件在WordPress的插件体系中,是SEO优化领域的重要工具,也是最为常用且功能强大的插件之一。当你成功安装并启用Yoast SEO插件后,首先要在插件的设置界面中,认真填写准确的网站信息,包括网站名称、简洁而精准的描述等关键内容。这些信息将成为搜索引擎认识和了解你网站的重要依据。在日常编辑文章时,Yoast SEO插件会成为你的优化助手,为你提供详细且实用的优化建议。它会根据你预先设定的关键词,对文章的可读性、关键词的分布密度等重要指标进行评估和提示。例如,它会通过直观的颜色标识和进度条展示,让你清晰地了解文章的优化状态,绿色表示文章在该方面优化效果良好,而红色则意味着需要你进一步调整和改进相关内容。此外,Yoast SEO插件还支持设置焦点关键词,帮助你在创作内容时能够紧密围绕关键词展开,确保文章主题明确、突出,从而更符合搜索引擎的算法规则。Yoast SEO插件官网:https://yoast.com/wordpress/plugins/seo/ 。 优化永久链接结构 构建合理的永久链接结构,对于搜索引擎准确识别页面内容至关重要。在WordPress后台的“设置 - 永久链接”选项中,强烈建议选择“文章名称”这一形式的链接结构。例如,若有一篇主题为“SEO优化基础”的文章,其链接可能呈现为“https://www.fulicode.cn/archives/189/” 。这样的链接清晰明了,直接包含了文章的核心关键词,使搜索引擎在抓取和索引页面时,能够迅速理解页面的主题和重点。此外,在链接的书写过程中,要恰当使用连字符“-”来分隔单词,避免使用下划线“_”。这是因为在搜索引擎的算法逻辑中,更倾向于识别由连字符分隔的单词,认为这样的链接结构更具语义性和可读性。 (二)Drupal 启用SEO相关模块 Drupal拥有丰富多样的模块生态系统,在这些众多的模块中,Metatag模块对于网站的SEO优化起着关键作用。一旦成功启用该模块,在内容编辑页面,你便可以便捷地自定义页面的元数据,其中包括元标题、元描述、元关键词等核心要素。这些精心设置的元数据,就像网站在搜索引擎中的“名片”,会直接影响搜索引擎对页面的展示方式以及在搜索结果中的排名位置。例如,一个精准且富有吸引力的元标题,能够在众多搜索结果中迅速吸引用户的注意力,大幅提高用户的点击率;而详细、准确的元描述,则能让用户在尚未点击进入页面之前,就对页面的大致内容有清晰的了解,从而增加用户点击的意愿。在设置元数据时,一定要注意关键词的合理分布,坚决杜绝关键词堆砌的现象,要让元数据自然流畅地融入页面信息中,符合搜索引擎的优化规则和用户的阅读习惯。 优化URL Drupal默认生成的URL往往较为复杂冗长,这种复杂的URL结构既不利于搜索引擎高效抓取页面内容,也给用户的记忆和分享带来不便。不过,借助Pathauto模块,你可以轻松实现URL的优化,自动生成简洁明了、富有语义的URL。在Pathauto模块的设置界面中,你可以根据网站内容的不同类型和分类等具体情况,灵活设置个性化的URL模式。比如,对于新闻类的内容,你可以将URL模式设置为“/news/[node:title - alias]” 。通过这样的设置,生成的URL不仅简洁美观,而且能够准确反映内容的主题和类别,更符合搜索引擎的喜好和用户的使用习惯。同时,需要特别注意的是,URL的长度不宜过长,一般建议尽量控制在100个字符以内。过长的URL可能会让搜索引擎在抓取和处理时遇到困难,也可能会降低用户在浏览和分享过程中的体验。Pathauto模块官网:https://www.drupal.org/project/pathauto 。 (三)Joomla 优化网站结构 确保网站具备清晰、合理的层次结构,是保障搜索引擎爬虫能够顺利抓取网站内容的关键前提。你可以通过合理设置菜单、分类等方式,对网站的内容进行科学、合理的组织和规划。例如,将网站的内容按照不同的主题划分为多个板块,在每个板块之下,再进一步细分具体的文章类别或者产品分类等。这样的结构布局,就像为用户和搜索引擎绘制了一张清晰的地图,使他们能够迅速、准确地找到自己所需的信息。在设置菜单时,要遵循简洁明了的原则,使用通俗易懂、能够准确概括内容的菜单名称,坚决避免使用那些模糊不清、生僻晦涩的词汇。同时,要对菜单的链接进行严格检查和测试,确保每个链接都能正常跳转,杜绝出现死链接的情况。因为死链接不仅会影响用户的浏览体验,还可能导致搜索引擎对网站的评价降低,进而影响网站的SEO排名。 安装SEO插件 JoomSEF是Joomla中一款广受欢迎且功能强大的SEO插件,它能够为你的网站URL优化工作提供全面支持,使其更符合搜索引擎的优化标准。在成功安装JoomSEF插件后,通过插件的设置界面,你可以轻松将动态URL转换为静态或伪静态URL。同时,该插件还提供了丰富的功能选项,让你能够方便地设置页面的元数据等重要信息。例如,原本像“index.php?option=com_content&view=article&id=123”这样复杂的动态URL,经过JoomSEF插件的优化处理后,可以转换为简洁且利于SEO的“/article/seo - optimization - tips”这样的静态URL。这种优化后的URL不仅能显著提高搜索引擎的抓取效率,还更方便用户记忆和分享。JoomSEF插件官网:https://www.joomsef.com/ 。 二、自己写的程序的优化 优化代码结构 确保代码简洁、规范,是提升网站性能和SEO效果的重要基础。在实际开发过程中,要尽可能避免出现冗余代码。例如,合理运用CSS和JavaScript的压缩工具,能够有效减少文件的大小,从而显著加快页面的加载速度。以UglifyJS工具为例,它可以对JavaScript代码进行深度压缩,去除代码中不必要的空格、注释以及冗余的代码片段,在不影响代码功能的前提下,极大地精简代码体积。同时,在编写HTML代码时,要充分运用语义化的HTML标签,如、、、等。这些语义化标签具有明确的语义和功能定义,能够让搜索引擎更准确地理解页面的结构和内容。例如,使用标签来定义页面的头部区域,搜索引擎就能迅速识别出该区域的功能和作用,从而在抓取和索引页面时,能够更精准地把握页面的关键信息。UglifyJS官网:https://github.com/mishoo/UglifyJS 。 设置合理的标题和元描述 在每个页面的 < head > 标签中,精心设置准确、富有吸引力的标题(< title >标签)和元描述(标签)至关重要。标题作为页面在搜索引擎结果页面中展示的重要信息,一定要包含核心关键词,并且要注意长度适中,一般建议控制在60个字符左右。例如,“最佳SEO优化教程 - 提升网站排名的实用技巧”这样的标题,既精准涵盖了“SEO优化”这一核心关键词,又通过富有吸引力的表述方式,激发了用户的点击欲望。而元描述则需要简洁明了地概括页面的主要内容,同时要具备一定的吸引力,以吸引用户点击进入页面。元描述的长度通常建议在150 - 160个字符之间。例如,“本教程详细介绍了SEO优化的各个方面,从基础概念到高级技巧,全方位帮助你提升网站在搜索引擎中的排名,获取更多的流量和曝光机会。”这样的元描述,既能让用户快速了解页面的核心内容,又能有效地引导用户点击进入页面进行深入阅读。 优化图片 对于网页中不可或缺的图片元素,进行优化处理是提升网站性能和SEO效果的重要环节。首先,要对图片的大小进行压缩处理,在尽可能降低文件体积的同时,确保图片的清晰度不受明显影响。你可以借助在线图片压缩工具,如TinyPNG(官网:https://tinypng.com/ ),或者专业的图形编辑软件,如Adobe Photoshop等,来完成图片的压缩工作。其次,为图片添加alt属性是必不可少的步骤。alt属性的作用是对图片的内容进行描述,当图片由于各种原因无法正常显示时,用户和搜索引擎可以通过alt属性的内容了解图片的大致信息。例如,对于一张展示SEO优化技巧的图片,alt属性可以设置为“SEO优化技巧图示”。这样,无论是用户还是搜索引擎,在遇到图片无法显示的情况时,都能通过alt属性获取到图片所传达的关键信息,从而保证了页面内容的完整性和可理解性。 创建XML网站地图 XML网站地图是一种能够帮助搜索引擎更好地抓取网站内容的重要工具。如果你使用的是WordPress网站,借助Yoast SEO插件(官网:https://yoast.com/wordpress/plugins/seo/ )就可以轻松生成XML网站地图。当然,你也可以选择自行编写代码来生成。在XML网站地图中,要全面、准确地列出网站的所有重要页面,包括文章页面、分类页面、产品页面等。完成网站地图的创建后,需要将其提交给各大搜索引擎,如百度站长平台(官网:https://ziyuan.baidu.com/ )、谷歌Search Console(官网:https://search.google.com/search - console )等。通过提交网站地图,搜索引擎能够及时、全面地发现和抓取网站的新内容,从而确保网站的页面能够在搜索引擎中得到及时的收录和更新,提高网站在搜索结果中的曝光率。 三、不开源程序的优化 分析现有代码 尽管面对不开源程序,我们无法直接对其代码进行修改,但我们可以对其现有代码进行深入细致的分析,从而了解其内部结构和运行机制。通过仔细查看页面的HTML、CSS和JavaScript代码,我们能够找出可能存在的影响SEO的因素。例如,是否存在大量的内联样式,这些内联样式可能会导致页面代码变得冗长繁杂,增加页面的加载时间;或者是否存在未经过优化的JavaScript代码,这些代码可能会占用过多的系统资源,影响页面的性能。如果发现页面中有大量的内联CSS样式,我们可以考虑与相关技术人员沟通,尝试将这些样式提取到外部CSS文件中,以优化页面代码结构,提高页面的加载速度和性能。 与开发者沟通 如果条件允许,积极与不开源程序的开发者进行沟通交流,是实现网站SEO优化的有效途径之一。在沟通时,要清晰、明确地向开发者阐述你的SEO优化需求。例如,你可以向开发者提出将动态URL修改为更有利于SEO的静态URL的请求,因为静态URL在搜索引擎的抓取和排名算法中往往具有更高的优先级。同时,你还可以请求开发者在页面中添加合适的元数据,如准确的页面标题、详细的元描述等,这些元数据对于提升页面在搜索引擎结果页面中的展示效果和点击率具有重要作用。开发者凭借其专业的技术知识和对程序的深入了解,可能会根据你的合理需求,对程序进行相应的调整和优化,从而为网站的SEO优化工作提供有力的支持。 利用第三方工具辅助优化 借助功能强大的第三方工具,能够有效地辅助提升不开源程序网站的SEO性能。以GTmetrix(官网:https://gtmetrix.com/ )为例,它是一款专业的网站性能分析工具,通过对网站的加载速度、页面性能等多个方面进行全面、深入的分析,为你提供详细的优化建议。你可以根据这些建议,采取针对性的优化措施,如优化图片质量和大小、压缩CSS和JavaScript文件、启用浏览器缓存等,从而显著提高网站的加载速度和用户体验。同时,百度站长平台(官网:https://ziyuan.baidu.com/ )和谷歌Search Console(官网:https://search.google.com/search - console )等工具也是不可或缺的。通过这些工具,你可以实时监测网站的收录情况、关键词排名等重要数据,及时发现网站在SEO方面存在的问题,并根据数据反馈进行相应的调整和优化,确保网站始终保持良好的SEO状态。 -

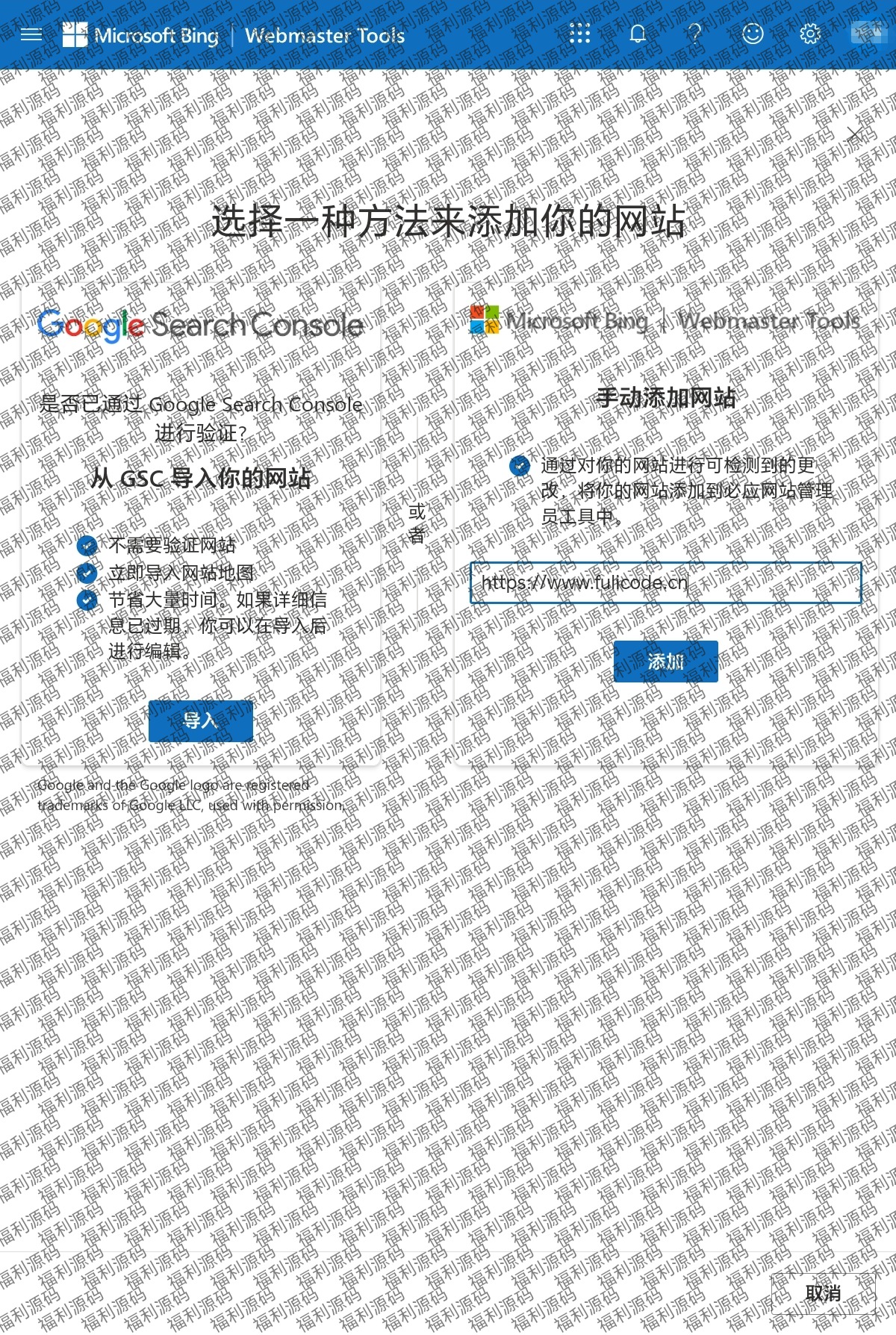

巧用 Bing 网站管理员工具,快速提升网站 Bing 权重 巧用Bing网站管理员工具,快速提升网站Bing权重 在互联网蓬勃发展的当下,网站的权重已然成为衡量其在网络世界中影响力的关键指标。无论是企业希望通过网站拓展业务、提升品牌知名度,还是个人期望凭借网站分享知识、展示才华,高权重的网站都能带来更多的流量与曝光机会。Bing作为全球知名的搜索引擎,其网站管理员工具蕴含着一系列强大且实用的功能,为我们提升网站在Bing搜索引擎中的权重提供了有效途径。接下来,就为大家详细剖析如何巧妙运用这些工具,实现网站权重的快速提升。 一、基础设置与验证 (一)注册与登录 如果你是完全的新手,不用担心,注册和登录Bing网站管理员工具非常简单。首先,打开你常用的浏览器,在地址栏中准确输入Bing网站管理员工具的官方网站网址https://www.bing.com/webmasters/ 。等页面加载完成后,你会看到一个很清晰的登录与注册界面。Bing借助微软账号体系,给我们带来了极大的便利。要是你已经有了Outlook邮箱账号、OneDrive账号或者Xbox Live账号等,都能直接用来登录Bing网站管理员工具,不用再重新注册,节省了很多时间。整个过程一般几分钟就能完成,这样你就能快速开启网站管理的第一步啦。 (二)网站所有权验证 成功登录后,验证网站所有权是必须要做的重要一步,只有通过验证,你才能使用Bing网站管理员工具的全部功能。Bing提供了好几种验证方式,不管你懂不懂技术,都能找到适合自己的方法。 HTML文件上传验证:选这种方式的话,Bing会生成一个专门的HTML文件,里面包含了验证网站所有权的关键信息。然后,你要通过网站的文件管理系统,把这个文件上传到网站的根目录。不同的网站建设平台找根目录的方法不太一样。比如在一些虚拟主机控制面板里,通过文件管理器进到网站的主目录,这个主目录就是根目录。上传完后,回到Bing网站管理员工具的验证页面https://www.bing.com/webmasters/verification ,点击验证按钮,Bing会用特定的算法检查网站根目录里有没有这个文件,来确认你对网站的所有权。整个上传和验证过程,熟练的话可能十几分钟就能搞定,新手可能需要半小时左右。 HTML标签验证:这种方法需要你在网站首页的HTML代码的Head部分添加Bing提供的meta标签。如果你对HTML代码有点了解,操作起来就不难。你可以在网站的后台管理系统里,找“主题设置”“自定义代码”等相关选项,找到编辑网站首页HTML代码的入口。把Bing提供的meta标签完整准确地粘贴到Head部分,保存好更改后,Bing就能通过扫描网页代码来验证网站所有权了。在Bing网站管理员工具中关于HTML标签验证的说明页面https://www.bing.com/webmasters/help/how-to-verify-your-site-4432740 有详细指导。这个过程大概需要20 - 30分钟,主要时间花在找代码入口和粘贴标签上。 DNS验证:DNS验证相对来说技术要求高一些。它涉及到对网站域名系统(DNS)的设置。Bing会给你一个特定的DNS记录值,你得登录到域名注册商的管理界面,在DNS设置区域添加一条新记录。记录的类型、名称和值都要按Bing的要求准确填写。添加完后,因为DNS系统在全球传播需要时间,一般几分钟到几小时不等,Bing会在传播完成后进行验证。Bing网站管理员工具中关于DNS验证的帮助页面https://www.bing.com/webmasters/help/dns-verification-3f0c574 能为你提供更多指引。所以从开始设置到完成验证,可能需要几个小时甚至一天的时间,具体要看DNS传播的速度。 网站所有权验证图片 二、网站地图提交与优化 (一)生成网站地图 网站地图就像一张详细的地图,能让搜索引擎清楚地知道网站的结构和内容分布,是搜索引擎高效抓取网站的重要依据。 WordPress建站系统:如果你的网站是用WordPress搭建的,Yoast SEO插件是生成网站地图的好帮手。你可以在WordPress的插件市场https://wordpress.org/plugins/ 里搜索Yoast SEO,然后安装并激活它。安装好后,在插件的设置界面很容易就能找到网站地图生成的相关选项。Yoast SEO不仅能自动扫描网站的页面、文章、分类等内容,生成全面的XML网站地图,还能让你进行很多优化设置。比如,你可以设置哪些页面或内容类型要包含在网站地图里,哪些可以不包含;还能调整页面在地图中的优先级,把重要的页面优先级设高一点,让搜索引擎优先抓取。整个安装插件和生成网站地图的过程,快的话十几分钟,慢的话半小时也能完成。 其他建站系统或独立网站:要是你的网站是用其他建站系统或者是独立开发的,在线网站地图生成工具是个不错的选择。像XML - Sitemaps.comhttps://www.xml-sitemaps.com/ 等就是很有名的在线工具。使用的时候,你只要在工具的界面输入网站的网址,选择要包含的页面类型,比如所有页面或者只是特定目录下的页面,再设置一下页面更新频率等参数,工具就会根据你给的信息,生成符合标准的XML网站地图。生成的地图文件可以下载保存到本地,留着后面提交用。这个过程大概20分钟左右就能完成,主要是填写信息和等待生成地图的时间。 (二)提交网站地图 在Bing网站管理员工具的操作界面里,仔细找“网站地图”相关选项,这个选项一般在“网站配置”“索引”等相关菜单下面,具体可参考https://www.bing.com/webmasters/sitemaps 。找到后,点击进入提交页面,把之前生成好的网站地图的URL地址准确地填到指定的输入框里,然后点击提交按钮。提交成功后,Bing搜索引擎会马上启动抓取程序,按照网站地图里列出的链接,有计划地抓取网站的页面内容。一般提交后,Bing会在几小时到一天内开始抓取,不过要让网站所有页面都被索引收录,可能需要几天到几周的时间,这要看网站的规模和内容更新情况。 网站地图提交图片 三、优化网站内容与结构 (一)关键词研究与布局 利用关键词研究工具:Bing网站管理员工具里的关键词研究工具非常好用。你可以在https://www.bing.com/webmasters/keywords 进入该工具界面,输入和你网站主题紧密相关的核心词汇,比如你的网站是卖户外运动装备的,就可以输入“户外运动装备”“登山鞋”“露营帐篷”等。工具很快就会给你一堆有价值的数据。 搜索量:这个数据能告诉你这个关键词在Bing搜索引擎上被用户搜索的次数,搜索量越高,说明这个词越热门,潜在的用户需求也就越大。 竞争程度:它反映了这个关键词在搜索引擎结果页面(SERP)上的竞争激烈程度。竞争程度高,就意味着很多网站都在争这个关键词的排名,优化起来难度大;竞争程度低的话,你就更有机会获得好的排名。 相关衍生关键词:工具还会给出和你输入关键词相关的其他词汇,这些可能是用户搜索时用的变体、近义词或者相关的长尾关键词。比如你输入“登山鞋”,可能就会出现“防水登山鞋”“男士登山鞋品牌推荐”等。这个关键词研究过程,每次输入不同关键词进行查询分析,大概10 - 15分钟就能完成一次。 选择合适的关键词:通过对这些数据的仔细分析,你就能选出一些搜索量适中而且竞争相对小的关键词。搜索量适中说明有一定的用户需求,竞争小又让你更有机会在搜索结果中排名靠前。比如在“户外运动装备”这个大主题下,“小众户外运动装备推荐”这个关键词,搜索量虽然比不上“户外运动装备”,但竞争程度低,对于一些中小规模的户外运动网站来说,就是个不错的选择。选择关键词的过程,可能需要花费几个小时,你要多尝试不同的关键词组合,分析数据后才能确定最合适的。 关键词布局策略:选好关键词后,怎么把它们合理地放在网站里很关键。 标题:文章标题很重要,既能吸引用户点击,又能让搜索引擎知道页面主题。在标题里自然地加入主要关键词,像“[品牌名]小众户外运动装备推荐,开启独特户外之旅”,这样的标题既能准确说明页面内容,又能吸引对小众户外运动装备感兴趣的用户。 正文:在文章正文中,要合理地多次出现关键词,但注意别堆砌,要让内容读起来自然流畅。可以在段落的开头、结尾以及重要观点阐述的地方适当出现关键词,让搜索引擎清楚地明白页面内容和关键词的关系。 图片替代文本:给网站里的图片加上包含关键词的替代文本,这样不仅能帮助搜索引擎理解图片内容,要是图片显示不出来,也能给用户提供有用的信息。比如一张展示登山鞋的图片,替代文本可以设为“[品牌名]防水登山鞋细节展示”。关键词布局不是一次性就能完成的,每次更新网站内容时都要注意合理布局,是一个持续的过程。 关键词研究图片 (二)优化页面结构 简洁明了的导航栏:网站的导航栏就像网站的“交通枢纽”,设计得清晰合理,用户和搜索引擎爬虫就能很快找到想要的页面。导航栏的菜单选项要简洁直观,别弄太多复杂的分类和层级。比如一个电商网站的导航栏,可以设置“首页”“产品分类(像户外运动装备、健身器材等)”“品牌专区”“促销活动”“客户服务”等主要选项,这样用户和搜索引擎都能一眼找到自己需要的内容。优化导航栏可能需要几个小时到一天的时间,主要是思考怎么分类和布局更合理。虽然Bing网站管理员工具没有专门针对导航栏优化的独立页面,但在整体的网站优化指南https://www.bing.com/webmasters/help 中有相关建议可供参考。 合理使用内部链接:内部链接就像连接网站各个页面的“桥梁”,合理使用能让网站形成一个有机的网络结构,提升网站整体权重。比如在一篇介绍电子产品的文章里,可以添加指向同类产品介绍页面或相关技术文章页面的链接。像介绍一款智能手机的文章,就可以加指向该品牌其他型号手机介绍页面的链接,还有关于手机摄影技术文章的链接。这样做既能让用户在浏览网站时方便找到更多相关信息,提升用户体验,又能引导搜索引擎爬虫深入抓取网站更多内容,让搜索引擎更好地理解网站页面之间的关系和网站整体主题,从而提升网站整体权重。内部链接的设置也是一个持续的工作,随着网站内容的增加,要不断完善内部链接结构。同样,Bing网站管理员工具关于网站结构优化的部分https://www.bing.com/webmasters/help 对内部链接设置有一定的指导意义。 四、数据监测与问题解决 (一)定期查看数据报告 Bing网站管理员工具提供了很多详细的数据报告,这些报告就像网站的“体检报告”,能让我们清楚地知道网站在Bing搜索结果中的表现。 搜索性能报告:你可以在https://www.bing.com/webmasters/search-performance 查看搜索性能报告,通过它,你能得到网站在Bing搜索结果中的很多关键数据。 展示次数:这表示网站页面在Bing搜索结果中被展示的总次数,展示次数越多,说明网站在搜索结果中的曝光机会越多。 点击次数:就是用户从Bing搜索结果中点击进入网站页面的实际次数。点击次数和展示次数的比例(点击率)能反映出网站页面在搜索结果中的吸引力。 关键词排名情况:这里会详细列出网站用的关键词在Bing搜索结果中的具体排名位置。通过跟踪关键词排名的变化,你就能知道优化工作有没有效果。建议你每周至少查看一次搜索性能报告,每次查看分析大概需要30分钟左右。 索引报告:在https://www.bing.com/webmasters/index-report 可以查看索引报告,它主要展示网站页面被Bing索引的情况。通过它,你能知道哪些页面被Bing成功索引了,哪些页面存在索引问题。要是发现有很多页面没被索引,可能是网站的某些设置阻碍了Bing爬虫的抓取,或者页面内容不符合搜索引擎规范。这时候,就需要深入分析原因并采取相应的解决措施。同样,建议每周查看一次索引报告,查看时间大概20分钟左右。 数据展示页图片 (二)解决抓取和索引问题 抓取问题排查与修复:在Bing网站管理员工具的“抓取问题”板块https://www.bing.com/webmasters/crawl-issues ,会详细列出Bing在抓取网站过程中遇到的各种错误信息。 页面无法访问:可能是网站服务器故障、页面链接错误或者网站设置了访问限制等原因造成的。要是服务器故障,要马上联系服务器提供商排查修复;如果是链接错误,就要检查网站的页面链接对不对,特别是网站改版、页面迁移后,一定要确保所有链接都能正常访问;要是访问限制问题,就得检查网站的防火墙设置、.htaccess文件等,保证Bing爬虫能正常访问网站页面。修复页面无法访问问题的时间不确定,服务器故障可能需要几个小时到几天才能解决,链接错误和访问限制问题,熟练的话可能几小时就能修复。 链接错误:包括死链接(无效链接)和重定向错误等。死链接会影响用户体验和搜索引擎爬虫的抓取,需要定期用工具检查网站的链接情况,及时把死链接修复或删除。对于重定向错误,要保证重定向设置正确,别出现循环重定向等问题。检查和修复链接错误,一次大概需要几个小时,具体要看网站规模和链接数量。 索引问题分析与解决:在“索引报告”中,要是发现有页面没被正确索引,就要仔细分析原因。可能是页面内容有问题,比如内容重复度过高、有很多低质量或无关的信息等。对于内容重复问题,可以通过创作原创内容、规范内容发布等方法解决;对于低质量内容,要优化和更新页面内容,提升内容的价值和相关性。也可能是网站的某些设置阻碍了索引,比如robots.txt文件错误地禁止了搜索引擎抓取某些页面,这时候就得检查robots.txt文件的设置,保证重要页面能被正常抓取索引。Bing网站管理员工具关于索引问题的帮助页面https://www.bing.com/webmasters/help/why-arent-my-pages-getting-indexed-4092409 能提供更多解决思路。解决索引问题的时间也不一样,内容问题可能需要几天到几周来更新优化,robots.txt文件设置问题,检查和修改可能几个小时就能完成。 及时解决这些抓取和索引问题,能保证网站正常被收录和权重提升。要是问题一直不解决,不仅会影响网站在Bing搜索结果中的展示,还可能让网站权重下降,用户流量流失。 三、效果 效果图片 总结 总之,Bing网站管理员工具是提升网站Bing权重的有力助手。通过合理运用上述方法,从基础设置到内容优化,再到数据监测与问题解决,持续不断地进行改进和完善,一般来说,3 - 6个月就能看到网站在Bing搜索引擎中的权重有明显提升,获得更多的流量和曝光机会,在互联网的广阔天地中绽放光彩。

巧用 Bing 网站管理员工具,快速提升网站 Bing 权重 巧用Bing网站管理员工具,快速提升网站Bing权重 在互联网蓬勃发展的当下,网站的权重已然成为衡量其在网络世界中影响力的关键指标。无论是企业希望通过网站拓展业务、提升品牌知名度,还是个人期望凭借网站分享知识、展示才华,高权重的网站都能带来更多的流量与曝光机会。Bing作为全球知名的搜索引擎,其网站管理员工具蕴含着一系列强大且实用的功能,为我们提升网站在Bing搜索引擎中的权重提供了有效途径。接下来,就为大家详细剖析如何巧妙运用这些工具,实现网站权重的快速提升。 一、基础设置与验证 (一)注册与登录 如果你是完全的新手,不用担心,注册和登录Bing网站管理员工具非常简单。首先,打开你常用的浏览器,在地址栏中准确输入Bing网站管理员工具的官方网站网址https://www.bing.com/webmasters/ 。等页面加载完成后,你会看到一个很清晰的登录与注册界面。Bing借助微软账号体系,给我们带来了极大的便利。要是你已经有了Outlook邮箱账号、OneDrive账号或者Xbox Live账号等,都能直接用来登录Bing网站管理员工具,不用再重新注册,节省了很多时间。整个过程一般几分钟就能完成,这样你就能快速开启网站管理的第一步啦。 (二)网站所有权验证 成功登录后,验证网站所有权是必须要做的重要一步,只有通过验证,你才能使用Bing网站管理员工具的全部功能。Bing提供了好几种验证方式,不管你懂不懂技术,都能找到适合自己的方法。 HTML文件上传验证:选这种方式的话,Bing会生成一个专门的HTML文件,里面包含了验证网站所有权的关键信息。然后,你要通过网站的文件管理系统,把这个文件上传到网站的根目录。不同的网站建设平台找根目录的方法不太一样。比如在一些虚拟主机控制面板里,通过文件管理器进到网站的主目录,这个主目录就是根目录。上传完后,回到Bing网站管理员工具的验证页面https://www.bing.com/webmasters/verification ,点击验证按钮,Bing会用特定的算法检查网站根目录里有没有这个文件,来确认你对网站的所有权。整个上传和验证过程,熟练的话可能十几分钟就能搞定,新手可能需要半小时左右。 HTML标签验证:这种方法需要你在网站首页的HTML代码的Head部分添加Bing提供的meta标签。如果你对HTML代码有点了解,操作起来就不难。你可以在网站的后台管理系统里,找“主题设置”“自定义代码”等相关选项,找到编辑网站首页HTML代码的入口。把Bing提供的meta标签完整准确地粘贴到Head部分,保存好更改后,Bing就能通过扫描网页代码来验证网站所有权了。在Bing网站管理员工具中关于HTML标签验证的说明页面https://www.bing.com/webmasters/help/how-to-verify-your-site-4432740 有详细指导。这个过程大概需要20 - 30分钟,主要时间花在找代码入口和粘贴标签上。 DNS验证:DNS验证相对来说技术要求高一些。它涉及到对网站域名系统(DNS)的设置。Bing会给你一个特定的DNS记录值,你得登录到域名注册商的管理界面,在DNS设置区域添加一条新记录。记录的类型、名称和值都要按Bing的要求准确填写。添加完后,因为DNS系统在全球传播需要时间,一般几分钟到几小时不等,Bing会在传播完成后进行验证。Bing网站管理员工具中关于DNS验证的帮助页面https://www.bing.com/webmasters/help/dns-verification-3f0c574 能为你提供更多指引。所以从开始设置到完成验证,可能需要几个小时甚至一天的时间,具体要看DNS传播的速度。 网站所有权验证图片 二、网站地图提交与优化 (一)生成网站地图 网站地图就像一张详细的地图,能让搜索引擎清楚地知道网站的结构和内容分布,是搜索引擎高效抓取网站的重要依据。 WordPress建站系统:如果你的网站是用WordPress搭建的,Yoast SEO插件是生成网站地图的好帮手。你可以在WordPress的插件市场https://wordpress.org/plugins/ 里搜索Yoast SEO,然后安装并激活它。安装好后,在插件的设置界面很容易就能找到网站地图生成的相关选项。Yoast SEO不仅能自动扫描网站的页面、文章、分类等内容,生成全面的XML网站地图,还能让你进行很多优化设置。比如,你可以设置哪些页面或内容类型要包含在网站地图里,哪些可以不包含;还能调整页面在地图中的优先级,把重要的页面优先级设高一点,让搜索引擎优先抓取。整个安装插件和生成网站地图的过程,快的话十几分钟,慢的话半小时也能完成。 其他建站系统或独立网站:要是你的网站是用其他建站系统或者是独立开发的,在线网站地图生成工具是个不错的选择。像XML - Sitemaps.comhttps://www.xml-sitemaps.com/ 等就是很有名的在线工具。使用的时候,你只要在工具的界面输入网站的网址,选择要包含的页面类型,比如所有页面或者只是特定目录下的页面,再设置一下页面更新频率等参数,工具就会根据你给的信息,生成符合标准的XML网站地图。生成的地图文件可以下载保存到本地,留着后面提交用。这个过程大概20分钟左右就能完成,主要是填写信息和等待生成地图的时间。 (二)提交网站地图 在Bing网站管理员工具的操作界面里,仔细找“网站地图”相关选项,这个选项一般在“网站配置”“索引”等相关菜单下面,具体可参考https://www.bing.com/webmasters/sitemaps 。找到后,点击进入提交页面,把之前生成好的网站地图的URL地址准确地填到指定的输入框里,然后点击提交按钮。提交成功后,Bing搜索引擎会马上启动抓取程序,按照网站地图里列出的链接,有计划地抓取网站的页面内容。一般提交后,Bing会在几小时到一天内开始抓取,不过要让网站所有页面都被索引收录,可能需要几天到几周的时间,这要看网站的规模和内容更新情况。 网站地图提交图片 三、优化网站内容与结构 (一)关键词研究与布局 利用关键词研究工具:Bing网站管理员工具里的关键词研究工具非常好用。你可以在https://www.bing.com/webmasters/keywords 进入该工具界面,输入和你网站主题紧密相关的核心词汇,比如你的网站是卖户外运动装备的,就可以输入“户外运动装备”“登山鞋”“露营帐篷”等。工具很快就会给你一堆有价值的数据。 搜索量:这个数据能告诉你这个关键词在Bing搜索引擎上被用户搜索的次数,搜索量越高,说明这个词越热门,潜在的用户需求也就越大。 竞争程度:它反映了这个关键词在搜索引擎结果页面(SERP)上的竞争激烈程度。竞争程度高,就意味着很多网站都在争这个关键词的排名,优化起来难度大;竞争程度低的话,你就更有机会获得好的排名。 相关衍生关键词:工具还会给出和你输入关键词相关的其他词汇,这些可能是用户搜索时用的变体、近义词或者相关的长尾关键词。比如你输入“登山鞋”,可能就会出现“防水登山鞋”“男士登山鞋品牌推荐”等。这个关键词研究过程,每次输入不同关键词进行查询分析,大概10 - 15分钟就能完成一次。 选择合适的关键词:通过对这些数据的仔细分析,你就能选出一些搜索量适中而且竞争相对小的关键词。搜索量适中说明有一定的用户需求,竞争小又让你更有机会在搜索结果中排名靠前。比如在“户外运动装备”这个大主题下,“小众户外运动装备推荐”这个关键词,搜索量虽然比不上“户外运动装备”,但竞争程度低,对于一些中小规模的户外运动网站来说,就是个不错的选择。选择关键词的过程,可能需要花费几个小时,你要多尝试不同的关键词组合,分析数据后才能确定最合适的。 关键词布局策略:选好关键词后,怎么把它们合理地放在网站里很关键。 标题:文章标题很重要,既能吸引用户点击,又能让搜索引擎知道页面主题。在标题里自然地加入主要关键词,像“[品牌名]小众户外运动装备推荐,开启独特户外之旅”,这样的标题既能准确说明页面内容,又能吸引对小众户外运动装备感兴趣的用户。 正文:在文章正文中,要合理地多次出现关键词,但注意别堆砌,要让内容读起来自然流畅。可以在段落的开头、结尾以及重要观点阐述的地方适当出现关键词,让搜索引擎清楚地明白页面内容和关键词的关系。 图片替代文本:给网站里的图片加上包含关键词的替代文本,这样不仅能帮助搜索引擎理解图片内容,要是图片显示不出来,也能给用户提供有用的信息。比如一张展示登山鞋的图片,替代文本可以设为“[品牌名]防水登山鞋细节展示”。关键词布局不是一次性就能完成的,每次更新网站内容时都要注意合理布局,是一个持续的过程。 关键词研究图片 (二)优化页面结构 简洁明了的导航栏:网站的导航栏就像网站的“交通枢纽”,设计得清晰合理,用户和搜索引擎爬虫就能很快找到想要的页面。导航栏的菜单选项要简洁直观,别弄太多复杂的分类和层级。比如一个电商网站的导航栏,可以设置“首页”“产品分类(像户外运动装备、健身器材等)”“品牌专区”“促销活动”“客户服务”等主要选项,这样用户和搜索引擎都能一眼找到自己需要的内容。优化导航栏可能需要几个小时到一天的时间,主要是思考怎么分类和布局更合理。虽然Bing网站管理员工具没有专门针对导航栏优化的独立页面,但在整体的网站优化指南https://www.bing.com/webmasters/help 中有相关建议可供参考。 合理使用内部链接:内部链接就像连接网站各个页面的“桥梁”,合理使用能让网站形成一个有机的网络结构,提升网站整体权重。比如在一篇介绍电子产品的文章里,可以添加指向同类产品介绍页面或相关技术文章页面的链接。像介绍一款智能手机的文章,就可以加指向该品牌其他型号手机介绍页面的链接,还有关于手机摄影技术文章的链接。这样做既能让用户在浏览网站时方便找到更多相关信息,提升用户体验,又能引导搜索引擎爬虫深入抓取网站更多内容,让搜索引擎更好地理解网站页面之间的关系和网站整体主题,从而提升网站整体权重。内部链接的设置也是一个持续的工作,随着网站内容的增加,要不断完善内部链接结构。同样,Bing网站管理员工具关于网站结构优化的部分https://www.bing.com/webmasters/help 对内部链接设置有一定的指导意义。 四、数据监测与问题解决 (一)定期查看数据报告 Bing网站管理员工具提供了很多详细的数据报告,这些报告就像网站的“体检报告”,能让我们清楚地知道网站在Bing搜索结果中的表现。 搜索性能报告:你可以在https://www.bing.com/webmasters/search-performance 查看搜索性能报告,通过它,你能得到网站在Bing搜索结果中的很多关键数据。 展示次数:这表示网站页面在Bing搜索结果中被展示的总次数,展示次数越多,说明网站在搜索结果中的曝光机会越多。 点击次数:就是用户从Bing搜索结果中点击进入网站页面的实际次数。点击次数和展示次数的比例(点击率)能反映出网站页面在搜索结果中的吸引力。 关键词排名情况:这里会详细列出网站用的关键词在Bing搜索结果中的具体排名位置。通过跟踪关键词排名的变化,你就能知道优化工作有没有效果。建议你每周至少查看一次搜索性能报告,每次查看分析大概需要30分钟左右。 索引报告:在https://www.bing.com/webmasters/index-report 可以查看索引报告,它主要展示网站页面被Bing索引的情况。通过它,你能知道哪些页面被Bing成功索引了,哪些页面存在索引问题。要是发现有很多页面没被索引,可能是网站的某些设置阻碍了Bing爬虫的抓取,或者页面内容不符合搜索引擎规范。这时候,就需要深入分析原因并采取相应的解决措施。同样,建议每周查看一次索引报告,查看时间大概20分钟左右。 数据展示页图片 (二)解决抓取和索引问题 抓取问题排查与修复:在Bing网站管理员工具的“抓取问题”板块https://www.bing.com/webmasters/crawl-issues ,会详细列出Bing在抓取网站过程中遇到的各种错误信息。 页面无法访问:可能是网站服务器故障、页面链接错误或者网站设置了访问限制等原因造成的。要是服务器故障,要马上联系服务器提供商排查修复;如果是链接错误,就要检查网站的页面链接对不对,特别是网站改版、页面迁移后,一定要确保所有链接都能正常访问;要是访问限制问题,就得检查网站的防火墙设置、.htaccess文件等,保证Bing爬虫能正常访问网站页面。修复页面无法访问问题的时间不确定,服务器故障可能需要几个小时到几天才能解决,链接错误和访问限制问题,熟练的话可能几小时就能修复。 链接错误:包括死链接(无效链接)和重定向错误等。死链接会影响用户体验和搜索引擎爬虫的抓取,需要定期用工具检查网站的链接情况,及时把死链接修复或删除。对于重定向错误,要保证重定向设置正确,别出现循环重定向等问题。检查和修复链接错误,一次大概需要几个小时,具体要看网站规模和链接数量。 索引问题分析与解决:在“索引报告”中,要是发现有页面没被正确索引,就要仔细分析原因。可能是页面内容有问题,比如内容重复度过高、有很多低质量或无关的信息等。对于内容重复问题,可以通过创作原创内容、规范内容发布等方法解决;对于低质量内容,要优化和更新页面内容,提升内容的价值和相关性。也可能是网站的某些设置阻碍了索引,比如robots.txt文件错误地禁止了搜索引擎抓取某些页面,这时候就得检查robots.txt文件的设置,保证重要页面能被正常抓取索引。Bing网站管理员工具关于索引问题的帮助页面https://www.bing.com/webmasters/help/why-arent-my-pages-getting-indexed-4092409 能提供更多解决思路。解决索引问题的时间也不一样,内容问题可能需要几天到几周来更新优化,robots.txt文件设置问题,检查和修改可能几个小时就能完成。 及时解决这些抓取和索引问题,能保证网站正常被收录和权重提升。要是问题一直不解决,不仅会影响网站在Bing搜索结果中的展示,还可能让网站权重下降,用户流量流失。 三、效果 效果图片 总结 总之,Bing网站管理员工具是提升网站Bing权重的有力助手。通过合理运用上述方法,从基础设置到内容优化,再到数据监测与问题解决,持续不断地进行改进和完善,一般来说,3 - 6个月就能看到网站在Bing搜索引擎中的权重有明显提升,获得更多的流量和曝光机会,在互联网的广阔天地中绽放光彩。 -

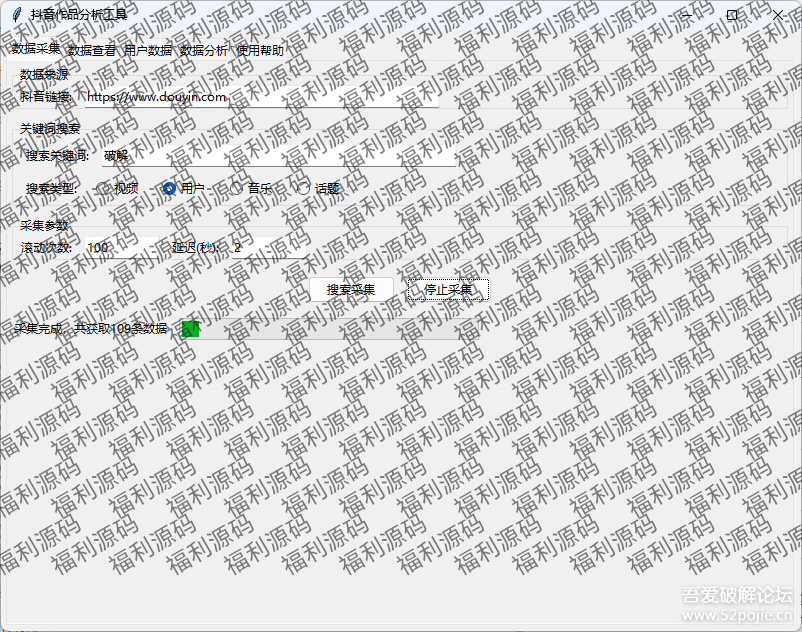

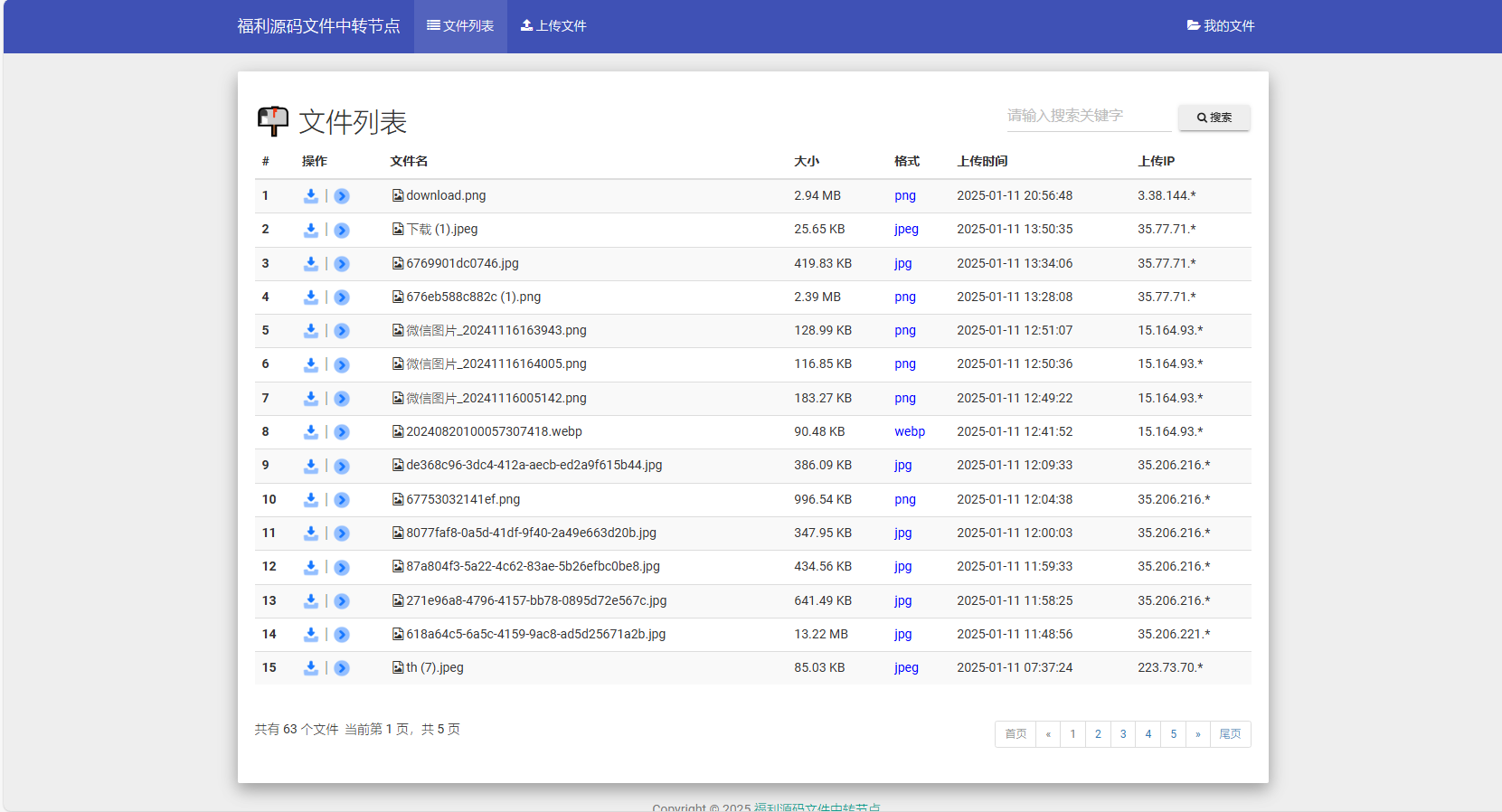

抖音数据采集分析工具 Python 源码免费下载 - 深度洞察抖音数据的利器 抖音数据采集分析工具Python源码免费大放送,开启数据洞察新征程 在当今数字化浪潮席卷全球的时代,数据已然成为各行各业发展的核心驱动力。尤其是在短视频领域,抖音作为行业的佼佼者,蕴含着海量的数据宝藏。为了帮助广大用户能够更加便捷、高效地挖掘这些数据背后的价值,我们怀着激动的心情向大家宣布——抖音作品数据采集分析工具的Python源码正式对外开放,而且完全免费! 这款精心打造的工具,堪称内容创作者与市场分析师的“得力神兵”。对于内容创作者来说,通过对抖音作品数据的深入分析,能够精准洞察观众的喜好与需求,从而创作出更贴合市场、更具吸引力的优质内容,提升自身在抖音平台的影响力与竞争力。对于市场分析师而言,该工具采集的丰富数据,能够为市场趋势研究、竞品分析等提供坚实的数据支撑,帮助企业制定更加科学、有效的市场策略。 截图 使用截图图片 一、技术细节与使用要点 (一)代码编写与调试 本工具的代码是基于cursor编写而成,这一技术架构为工具的数据采集与分析功能奠定了坚实的基础。然而,就像任何一款处于不断优化过程中的软件产品一样,目前代码存在部分报错情况,并且个别模块尚未调试完善。但这并非是阻碍,而是为广大技术爱好者提供了一个施展才华的舞台。对于那些拥有扎实技术功底、热衷于探索与创新的用户而言,这无疑是一次难得的机会。你可以深入到代码的世界中,通过自己的智慧和努力,对这些问题进行调试与优化,不仅能够让工具更加符合自己的使用需求,还能在这个过程中提升自己的编程技能。 (二)配置要求 在使用该工具之前,有一个关键的准备步骤,那就是用户需要自行配置谷歌浏览器驱动。谷歌浏览器驱动在工具的数据采集过程中起着至关重要的桥梁作用,它能够确保工具与浏览器之间的通信顺畅,从而实现高效的数据采集。虽然这一配置过程可能需要花费一些时间和精力,但当你成功完成配置,看到工具顺利运行并为你采集到所需的数据时,一切的付出都将得到丰厚的回报。 二、使用便捷性:代码获取方式 为了最大程度地方便大家获取,我们将代码精心保存为文件,并提供了云盘下载渠道。这种方式不仅确保了代码的完整性,还让用户能够轻松快捷地将代码下载到本地,随时开始自己的数据采集与分析之旅。 当然你也可以复制粘贴↓ #您下载的资源来着www.fulicode.cn import tkinter as tk from tkinter import ttk, messagebox from selenium import webdriver from selenium.webdriver.common.by import By from selenium.webdriver.support.ui import WebDriverWait from selenium.webdriver.support import expected_conditions as EC import time import threading import pandas as pd import json from datetime import datetime import os from urllib.parse import quote from bs4 import BeautifulSoup import jieba from collections import Counter import traceback class DouyinAnalyzer: def __init__(self, root): self.root = root self.root.title("抖音作品分析工具") self.root.geometry("800x600") # 创建变量 self.url = tk.StringVar(value="https://www.douyin.com") self.scroll_count = tk.StringVar(value="100") self.delay = tk.StringVar(value="2") self.is_running = False self.collected_data = [] # 创建界面 self.create_widgets() def create_widgets(self): # 创建notebook用于标签页 self.notebook = ttk.Notebook(self.root) self.notebook.pack(fill='both', expand=True, padx=5, pady=5) # 创建各个标签页 self.create_collection_tab() self.create_data_tab() self.create_user_data_tab() self.create_analysis_tab() self.create_help_tab() # 添加帮助标签页 def create_collection_tab(self): """创建数据采集标签页""" collection_frame = ttk.Frame(self.notebook) self.notebook.add(collection_frame, text='数据采集') # URL输入框 url_frame = ttk.LabelFrame(collection_frame, text='数据来源') url_frame.pack(fill='x', padx=5, pady=5) ttk.Label(url_frame, text="抖音链接:").pack(side='left', padx=5) ttk.Entry(url_frame, textvariable=self.url, width=50).pack(side='left', padx=5) # 添加搜索框架 search_frame = ttk.LabelFrame(collection_frame, text='关键词搜索') search_frame.pack(fill='x', padx=5, pady=5) # 搜索关键词输入 keyword_frame = ttk.Frame(search_frame) keyword_frame.pack(fill='x', padx=5, pady=5) ttk.Label(keyword_frame, text="搜索关键词:").pack(side='left', padx=5) self.search_keyword = tk.StringVar() ttk.Entry(keyword_frame, textvariable=self.search_keyword, width=50).pack(side='left', padx=5) # 搜索类型选择(单选框) type_frame = ttk.Frame(search_frame) type_frame.pack(fill='x', padx=5, pady=5) ttk.Label(type_frame, text="搜索类型:").pack(side='left', padx=5) self.search_type = tk.StringVar(value='video') search_types = [ ('视频', 'video'), ('用户', 'user'), ('音乐', 'music'), ('话题', 'hashtag') ] # 创建单选框 for text, value in search_types: ttk.Radiobutton( type_frame, text=text, value=value, variable=self.search_type ).pack(side='left', padx=10) # 参数设置框 param_frame = ttk.LabelFrame(collection_frame, text='采集参数') param_frame.pack(fill='x', padx=5, pady=5) ttk.Label(param_frame, text="滚动次数:").pack(side='left', padx=5) ttk.Entry(param_frame, textvariable=self.scroll_count, width=10).pack(side='left', padx=5) ttk.Label(param_frame, text="延迟(秒):").pack(side='left', padx=5) ttk.Entry(param_frame, textvariable=self.delay, width=10).pack(side='left', padx=5) # 按钮框 button_frame = ttk.Frame(collection_frame) button_frame.pack(pady=10) ttk.Button(button_frame, text="搜索采集", command=self.start_search_collection).pack(side='left', padx=5) ttk.Button(button_frame, text="停止采集", command=self.stop_collection).pack(side='left', padx=5) # 状态栏 status_frame = ttk.Frame(collection_frame) status_frame.pack(fill='x', pady=5) self.status_label = ttk.Label(status_frame, text="就绪") self.status_label.pack(side='left', padx=5) self.progress = ttk.Progressbar(status_frame, length=300, mode='determinate') self.progress.pack(side='left', padx=5) def create_data_tab(self): """创建数据查看标签页""" data_frame = ttk.Frame(self.notebook) self.notebook.add(data_frame, text='数据查看') # 创建工具栏 toolbar = ttk.Frame(data_frame) toolbar.pack(fill='x', padx=5, pady=5) # 添加导出按钮 ttk.Button(toolbar, text="导出Excel", command=self.export_excel).pack(side='left', padx=5) ttk.Button(toolbar, text="导出JSON", command=self.export_json).pack(side='left', padx=5) # 添加统计标签 self.stats_label = ttk.Label(toolbar, text="共采集到 0 条数据") self.stats_label.pack(side='right', padx=5) # 创建表格 columns = ('序号', '标题', '作者', '发布时间', '点赞数', '视频链接') self.data_tree = ttk.Treeview(data_frame, columns=columns, show='headings') # 设置列标题和宽度 for col in columns: self.data_tree.heading(col, text=col, command=lambda c=col: self.treeview_sort_column(self.data_tree, c, False)) # 设置列宽 self.data_tree.column('序号', width=50) self.data_tree.column('标题', width=200) self.data_tree.column('作者', width=100) self.data_tree.column('发布时间', width=100) self.data_tree.column('点赞数', width=70) self.data_tree.column('视频链接', width=200) # 添加滚动条 scrollbar = ttk.Scrollbar(data_frame, orient='vertical', command=self.data_tree.yview) self.data_tree.configure(yscrollcommand=scrollbar.set) # 使用grid布局管理器 self.data_tree.pack(side='left', fill='both', expand=True) scrollbar.pack(side='right', fill='y') # 绑定双击事件 self.data_tree.bind('<Double-1>', self.on_tree_double_click) def create_user_data_tab(self): """创建用户数据查看标签页""" user_frame = ttk.Frame(self.notebook) self.notebook.add(user_frame, text='用户数据') # 创建工具栏 toolbar = ttk.Frame(user_frame) toolbar.pack(fill='x', padx=5, pady=5) # 添加导出按钮 ttk.Button(toolbar, text="导出Excel", command=self.export_user_excel).pack(side='left', padx=5) ttk.Button(toolbar, text="导出JSON", command=self.export_user_json).pack(side='left', padx=5) # 添加统计标签 self.user_stats_label = ttk.Label(toolbar, text="共采集到 0 位用户") self.user_stats_label.pack(side='right', padx=5) # 创建表格 columns = ('序号', '用户名', '抖音号', '获赞数', '粉丝数', '简介', '主页链接', '头像链接') self.user_tree = ttk.Treeview(user_frame, columns=columns, show='headings') # 设置列标题和排序功能 for col in columns: self.user_tree.heading(col, text=col, command=lambda c=col: self.treeview_sort_column(self.user_tree, c, False)) # 设置列宽 self.user_tree.column('序号', width=50) self.user_tree.column('用户名', width=150) self.user_tree.column('抖音号', width=100) self.user_tree.column('获赞数', width=70) self.user_tree.column('粉丝数', width=70) self.user_tree.column('简介', width=200) self.user_tree.column('主页链接', width=150) self.user_tree.column('头像链接', width=150) # 添加滚动条 scrollbar = ttk.Scrollbar(user_frame, orient='vertical', command=self.user_tree.yview) self.user_tree.configure(yscrollcommand=scrollbar.set) # 布局 self.user_tree.pack(side='left', fill='both', expand=True) scrollbar.pack(side='right', fill='y') # 绑定双击事件 self.user_tree.bind('<Double-1>', self.on_user_tree_double_click) def on_tree_double_click(self, event): """处理表格双击事件""" try: item = self.data_tree.selection()[0] values = self.data_tree.item(item)['values'] if not values: return video_url = values[5] # 获取视频链接 if video_url: # 确保URL格式正确 if not video_url.startswith('http'): if video_url.startswith('//'): video_url = 'https:' + video_url elif video_url.startswith('/'): video_url = 'https://www.douyin.com' + video_url else: video_url = 'https://www.douyin.com/' + video_url # 使用默认浏览器打开链接 import webbrowser webbrowser.open(video_url) except Exception as e: print(f"打开视频链接错误: {str(e)}") messagebox.showerror("错误", "无法打开视频链接") def on_user_tree_double_click(self, event): """处理用户表格双击事件""" try: item = self.user_tree.selection()[0] values = self.user_tree.item(item)['values'] if not values: return user_url = values[6] # 获取用户主页链接 if user_url: # 确保URL格式正确 if not user_url.startswith('http'): if user_url.startswith('//'): user_url = 'https:' + user_url elif user_url.startswith('/'): user_url = 'https://www.douyin.com' + user_url else: user_url = 'https://www.douyin.com/' + user_url # 使用默认浏览器打开链接 import webbrowser webbrowser.open(user_url) except Exception as e: print(f"打开用户主页链接错误: {str(e)}") messagebox.showerror("错误", "无法打开用户主页链接") def create_analysis_tab(self): """创建数据分析标签页""" analysis_frame = ttk.Frame(self.notebook) self.notebook.add(analysis_frame, text='数据分析') # 创建分析结果文本框 self.analysis_text = tk.Text(analysis_frame, height=20, width=60) self.analysis_text.pack(pady=10, padx=10, fill='both', expand=True) # 创建按钮框架 button_frame = ttk.Frame(analysis_frame) button_frame.pack(pady=5) # 添加分析按钮 ttk.Button(button_frame, text="互动数据分析", command=self.analyze_interaction_data).pack(side='left', padx=5) ttk.Button(button_frame, text="内容长度分析", command=self.analyze_content_length).pack(side='left', padx=5) ttk.Button(button_frame, text="高频词汇分析", command=self.analyze_keywords).pack(side='left', padx=5) ttk.Button(button_frame, text="清空分析结果", command=lambda: self.analysis_text.delete(1.0, tk.END)).pack(side='left', padx=5) def start_search_collection(self): """开始搜索采集""" if self.is_running: messagebox.showwarning("警告", "采集正在进行中!") return self.is_running = True threading.Thread(target=self.scroll_and_collect_search).start() def scroll_and_collect_search(self): """滚动页面并收集搜索结果数据""" driver = None try: # 配置Chrome选项 chrome_options = webdriver.ChromeOptions() chrome_options.add_argument('--disable-gpu') chrome_options.add_argument('--no-sandbox') chrome_options.add_argument('--disable-dev-shm-usage') chrome_options.add_argument('--disable-extensions') chrome_options.add_argument('--disable-logging') chrome_options.add_argument('--log-level=3') # 启动浏览器 driver = webdriver.Chrome(options=chrome_options) # 构建搜索URL keyword = self.search_keyword.get().strip() if not keyword: messagebox.showwarning("警告", "请输入搜索关键词!") return search_type = self.search_type.get() search_url = f"https://www.douyin.com/search/{quote(keyword)}?source=normal_search&type={search_type}" print(f"访问搜索URL: {search_url}") # 访问页面 driver.get(search_url) driver.maximize_window() # 等待页面加载 try: if search_type == 'user': # 等待用户列表加载 WebDriverWait(driver, 10).until( EC.presence_of_element_located((By.CSS_SELECTOR, '#search-content-area')) ) # 额外等待确保内容完全加载 time.sleep(5) # 增加等待时间 else: # 等待视频列表加载 WebDriverWait(driver, 10).until( EC.presence_of_element_located((By.CSS_SELECTOR, 'li.SwZLHMKk')) ) except Exception as e: print(f"等待页面加载超时: {str(e)}") time.sleep(3) # 额外等待时间 # 获取滚动次数和延迟 scroll_times = int(self.scroll_count.get()) delay = float(self.delay.get()) # 开始滚动和采集 last_height = driver.execute_script("return document.body.scrollHeight") for i in range(scroll_times): if not self.is_running: break try: # 滚动页面 driver.execute_script("window.scrollTo(0, document.body.scrollHeight);") time.sleep(delay) # 检查是否到达底部 new_height = driver.execute_script("return document.body.scrollHeight") if new_height == last_height: print("已到达页面底部") break last_height = new_height # 获取页面源码并解析 page_source = driver.page_source soup = BeautifulSoup(page_source, 'html.parser') # 根据搜索类型选择不同的提取方法 if search_type == 'user': new_data = self.extract_user_data(soup) else: container = soup.select_one('[data-e2e="scroll-list"]') if container: new_data = self.extract_video_items(container) else: print("未找到视频列表容器") continue print(f"本次滚动找到 {len(new_data)} 条新数据") # 添加新数据(去重) for data in new_data: if data not in self.collected_data: self.collected_data.append(data) print(f"当前总共采集 {len(self.collected_data)} 条数据") # 更新数据显示 self.root.after(0, self.update_data_display) # 使用after确保在主线程中更新UI # 更新状态 self.status_label.config(text=f"正在滚动... ({i+1}/{scroll_times})") self.progress['value'] = (i + 1) / scroll_times * 100 except Exception as e: print(f"滚动错误: {str(e)}") continue print("搜索结果采集完成") self.status_label.config(text=f"采集完成,共获取{len(self.collected_data)}条数据") except Exception as e: print(f"搜索采集过程出错: {str(e)}") messagebox.showerror("错误", f"采集过程出错: {str(e)}") finally: self.is_running = False if driver: driver.quit() def extract_video_data(self, html): """提取数据""" if self.search_type.get() == 'user': return self.extract_user_data(html) else: return self.extract_video_items(html) def extract_user_data(self, html): """提取用户数据""" print("开始提取用户数据...") # 使用正确的选择器定位用户列表 user_items = html.select("div.search-result-card > a.hY8lWHgA.poLTDMYS") # 更新选择器 print(f"找到 {len(user_items)} 个用户项") user_data = [] for item in user_items: try: # 获取用户链接 user_link = item.get('href', '') # 获取标题 title_elem = item.select_one('div.XQwChAbX p.v9LWb7QE span span span span span') title = title_elem.get_text(strip=True) if title_elem else '' # 获取头像URL avatar_elem = item.select_one('img.RlLOO79h') avatar_url = avatar_elem.get('src', '') if avatar_elem else '' # 获取统计数据 stats_div = item.select_one('div.jjebLXt0') douyin_id = '' likes = '0' followers = '0' if stats_div: spans = stats_div.select('span') for span in spans: text = span.get_text(strip=True) print(f"处理span文本: {text}") # 调试输出 if '抖音号:' in text or '抖音号:' in text: id_span = span.select_one('span') if id_span: douyin_id = id_span.get_text(strip=True) elif '获赞' in text: likes = text.replace('获赞', '').strip() elif '粉丝' in text: followers = text.replace('粉丝', '').strip() # 获取简介 desc_elem = item.select_one('p.Kdb5Km3i span span span span span') description = desc_elem.get_text(strip=True) if desc_elem else '' # 构建数据 data = { 'title': title, 'douyin_id': douyin_id, 'likes': likes, 'followers': followers, 'description': description, 'avatar_url': avatar_url, 'user_link': user_link } # 清理数据 data = {k: self.clean_text(str(v)) for k, v in data.items()} # 格式化数字 data['likes'] = self.format_number(data['likes']) data['followers'] = self.format_number(data['followers']) # 处理用户链接 if data['user_link'] and not data['user_link'].startswith('http'): data['user_link'] = 'https://www.douyin.com' + data['user_link'] # 打印调试信息 print("\n提取到的数据:") for key, value in data.items(): print(f"{key}: {value}") # 只要有标题就添加 if data['title']: if data not in user_data: # 确保不重复添加 user_data.append(data) print(f"成功提取用户数据: {data['title']}") except Exception as e: print(f"提取单个用户数据错误: {str(e)}") traceback.print_exc() # 打印完整的错误堆栈 continue print(f"总共提取到 {len(user_data)} 条用户数据") return user_data def _extract_basic_info(self, item): """提取基本信息""" # 获取用户链接 user_link = item.select_one('a.uz1VJwFY') # 使用确切的类名 # 获取标题 title = "" title_elem = item.select_one('p.ZMZLqKYm span') # 使用确切的类名和结构 if title_elem: title = title_elem.get_text(strip=True) # 获取头像URL avatar_elem = item.select_one('img.fiWP27dC') avatar_url = avatar_elem.get('src', '') if avatar_elem else '' return { 'title': title, 'douyin_id': '', 'likes': '', 'followers': '', 'description': '', 'avatar_url': avatar_url, 'user_link': user_link.get('href', '') if user_link else '' } def _extract_stats_info(self, item, data): """提取统计信息""" stats_div = item.select_one('div.Y6iuJGlc') # 使用确切的类名 if stats_div: spans = stats_div.select('span') spans_text = [span.get_text(strip=True) for span in spans] print(f"找到的span文本: {spans_text}") # 调试输出 for text in spans_text: if '抖音号:' in text or '抖音号:' in text: # 获取嵌套的span中的抖音号 nested_span = stats_div.select_one('span > span') if nested_span: data['douyin_id'] = nested_span.get_text(strip=True) elif '获赞' in text: data['likes'] = text.replace('获赞', '').strip() elif '粉丝' in text: data['followers'] = text.replace('粉丝', '').strip() def _extract_description(self, item, data): """提取用户简介""" desc_elem = item.select_one('p.NYqiIDUo span') # 使用确切的类名和结构 if desc_elem: # 获取纯文本内容,去除表情图片 text_nodes = [node for node in desc_elem.stripped_strings] data['description'] = ' '.join(text_nodes) def _clean_and_format_data(self, data): """清理和格式化数据""" # 清理文本数据 for key in data: if isinstance(data[key], str): data[key] = self.clean_text(data[key]) # 格式化数字 data['likes'] = self.format_number(data['likes']) data['followers'] = self.format_number(data['followers']) # 处理用户链接 if data['user_link']: link = data['user_link'] # 移除查询参数 if '?' in link: link = link.split('?')[0] # 确保正确的格式 if link.startswith('//'): link = 'https:' + link elif not link.startswith('http'): # 移除可能的重复路径 link = link.replace('www.douyin.com/', '') link = link.replace('//', '/') if not link.startswith('/'): link = '/' + link link = 'https://www.douyin.com' + link print(f"原始链接: {data['user_link']}") # 调试输出 print(f"处理后链接: {link}") # 调试输出 data['user_link'] = link def _print_debug_info(self, data): """打印调试信息""" print("\n提取到的数据:") print(f"标题: {data['title']}") print(f"抖音号: {data['douyin_id']}") print(f"获赞: {data['likes']}") print(f"粉丝: {data['followers']}") print(f"简介: {data['description'][:50]}...") print(f"链接: {data['user_link']}") def extract_video_items(self, html): """提取视频数据(原有代码)""" video_items = html.select("li.SwZLHMKk") video_data = [] for item in video_items: try: # 获取视频链接 video_link = item.select_one('a.hY8lWHgA') if not video_link: continue # 构建数据 data = { 'video_url': video_link['href'].strip(), 'cover_image': item.select_one('img')['src'].strip() if item.select_one('img') else '', 'title': item.select_one('div.VDYK8Xd7').text.strip() if item.select_one('div.VDYK8Xd7') else '无标题', 'author': item.select_one('span.MZNczJmS').text.strip() if item.select_one('span.MZNczJmS') else '未知作者', 'publish_time': item.select_one('span.faDtinfi').text.strip() if item.select_one('span.faDtinfi') else '', 'likes': item.select_one('span.cIiU4Muu').text.strip() if item.select_one('span.cIiU4Muu') else '0' } # 清理数据 data = {k: self.clean_text(str(v)) for k, v in data.items()} # 验证数据完整性 if all(data.values()): video_data.append(data) else: print(f"跳过不完整数据: {data}") except Exception as e: print(f"提取单个视频数据错误: {str(e)}") continue return video_data def update_data_display(self): """更新数据显示""" try: search_type = self.search_type.get() print(f"更新数据显示,搜索类型: {search_type}") print(f"当前数据数量: {len(self.collected_data)}") if search_type == 'user': self.notebook.select(2) # 先切换到用户数据标签页 self.root.after(100, self.update_user_display) # 延迟一小段时间后更新显示 else: self.notebook.select(1) # 切换到视频数据标签页 self.root.after(100, self.update_video_display) except Exception as e: print(f"更新数据显示错误: {str(e)}") def update_user_display(self): """更新用户数据显示""" try: # 清空现有显示 self.user_tree.delete(*self.user_tree.get_children()) # 添加新数据 for i, data in enumerate(self.collected_data): try: # 格式化简介 description = data.get('description', '') if len(description) > 50: description = description[:47] + '...' # 格式化数据 values = ( i + 1, data.get('title', ''), data.get('douyin_id', ''), self.format_number(str(data.get('likes', '0'))), self.format_number(str(data.get('followers', '0'))), description, data.get('user_link', ''), data.get('avatar_url', '') ) self.user_tree.insert('', 'end', values=values) print(f"显示用户数据: {data.get('title', '')}") except Exception as e: print(f"处理单条用户数据显示错误: {str(e)}") continue # 更新统计 self.user_stats_label.config(text=f"共采集到 {len(self.collected_data)} 位用户") print(f"更新用户统计: {len(self.collected_data)} 位用户") # 自动滚动到最新数据 if self.user_tree.get_children(): self.user_tree.see(self.user_tree.get_children()[-1]) except Exception as e: print(f"更新用户数据显示错误: {str(e)}") def update_video_display(self): """更新视频数据显示(原有的update_data_display逻辑)""" try: # 清空现有显示 self.data_tree.delete(*self.data_tree.get_children()) # 添加新数据 for i, data in enumerate(self.collected_data): try: title = data.get('title', '') if len(title) > 50: title = title[:47] + '...' values = ( i + 1, title, data.get('author', '未知作者'), data.get('publish_time', ''), self.format_number(str(data.get('likes', '0'))), data.get('video_url', '') ) self.data_tree.insert('', 'end', values=values) except Exception as e: print(f"处理单条数据显示错误: {str(e)}") continue # 更新统计 self.stats_label.config(text=f"共采集到 {len(self.collected_data)} 条数据") # 自动滚动到最新数据 if self.data_tree.get_children(): self.data_tree.see(self.data_tree.get_children()[-1]) except Exception as e: print(f"更新数据显示错误: {str(e)}") def update_data_stats(self): """更新数据统计""" try: total_count = len(self.collected_data) self.stats_label.config(text=f"共采集到 {total_count} 条数据") except Exception as e: print(f"更新统计信息错误: {str(e)}") def stop_collection(self): """停止数据采集""" if self.is_running: self.is_running = False self.status_label.config(text="已停止采集") print("采集已停止") else: print("当前没有正在进行的采集任务") def export_excel(self): """导出数据到Excel""" if not self.collected_data: messagebox.showwarning("警告", "没有数据可导出!") return try: filename = f"抖音数据_{datetime.now().strftime('%Y%m%d_%H%M%S')}.xlsx" df = pd.DataFrame(self.collected_data) df.to_excel(filename, index=False) messagebox.showinfo("成功", f"数据已导出到: {filename}") except Exception as e: messagebox.showerror("错误", f"导出Excel失败: {str(e)}") def export_json(self): """导出数据到JSON""" if not self.collected_data: messagebox.showwarning("警告", "没有数据可导出!") return try: filename = f"抖音数据_{datetime.now().strftime('%Y%m%d_%H%M%S')}.json" with open(filename, 'w', encoding='utf-8') as f: json.dump(self.collected_data, f, ensure_ascii=False, indent=2) messagebox.showinfo("成功", f"数据已导出到: {filename}") except Exception as e: messagebox.showerror("错误", f"导出JSON失败: {str(e)}") def export_user_excel(self): """导出用户数据到Excel""" if not self.collected_data or self.search_type.get() != 'user': messagebox.showwarning("警告", "没有用户数据可导出!") return try: filename = f"抖音用户数据_{datetime.now().strftime('%Y%m%d_%H%M%S')}.xlsx" df = pd.DataFrame(self.collected_data) df.to_excel(filename, index=False) messagebox.showinfo("成功", f"用户数据已导出到: {filename}") except Exception as e: messagebox.showerror("错误", f"导出Excel失败: {str(e)}") def export_user_json(self): """导出用户数据到JSON""" if not self.collected_data or self.search_type.get() != 'user': messagebox.showwarning("警告", "没有用户数据可导出!") return try: filename = f"抖音用户数据_{datetime.now().strftime('%Y%m%d_%H%M%S')}.json" with open(filename, 'w', encoding='utf-8') as f: json.dump(self.collected_data, f, ensure_ascii=False, indent=2) messagebox.showinfo("成功", f"用户数据已导出到: {filename}") except Exception as e: messagebox.showerror("错误", f"导出JSON失败: {str(e)}") def clean_text(self, text): """清理文本""" return text.replace('\n', ' ').replace('\r', '').strip() def format_number(self, num_str): """格式化数字字符串""" try: num = int(num_str) if num >= 10000: return f"{num / 10000:.1f}万" return str(num) except ValueError: return num_str def analyze_interaction_data(self): """分析互动数据""" if not self.collected_data: messagebox.showwarning("警告", "没有可分析的数据!") return try: # 将点赞数转换为数字 likes_data = [] for data in self.collected_data: likes = str(data['likes']) try: if '万' in likes: # 处理带"万"的数字 num = float(likes.replace('万', '')) * 10000 likes_data.append(int(num)) else: # 处理普通数字 likes_data.append(int(likes)) except (ValueError, TypeError): print(f"无法解析的点赞数: {likes}") continue # 计算统计数据 total_likes = sum(likes_data) avg_likes = total_likes / len(likes_data) if likes_data else 0 max_likes = max(likes_data) if likes_data else 0 # 生成报告 report = "===== 互动数据分析报告 =====\n\n" report += f"总视频数: {len(self.collected_data)}\n" report += f"总点赞数: {self.format_large_number(total_likes)}\n" report += f"平均点赞数: {self.format_large_number(int(avg_likes))}\n" report += f"最高点赞数: {self.format_large_number(max_likes)}\n" # 显示分析结果 self.analysis_text.delete(1.0, tk.END) self.analysis_text.insert(tk.END, report) except Exception as e: print(f"互动数据分析错误: {str(e)}") messagebox.showerror("错误", f"分析失败: {str(e)}") def format_large_number(self, num): """格式化大数字显示""" if num >= 10000: return f"{num/10000:.1f}万" return str(num) def analyze_content_length(self): """分析内容长度""" if not self.collected_data: messagebox.showwarning("警告", "没有可分析的数据!") return try: # 计算标题长度 title_lengths = [len(data['title']) for data in self.collected_data] # 计算统计数据 avg_length = sum(title_lengths) / len(title_lengths) max_length = max(title_lengths) min_length = min(title_lengths) # 生成报告 report = "===== 内容长度分析报告 =====\n\n" report += f"平均标题长度: {avg_length:.1f}字\n" report += f"最长标题: {max_length}字\n" report += f"最短标题: {min_length}字\n\n" # 添加长度分布统计 length_ranges = [(0, 10), (11, 20), (21, 30), (31, 50), (51, 100), (101, float('inf'))] report += "标题长度分布:\n" for start, end in length_ranges: count = sum(1 for length in title_lengths if start <= length <= end) range_text = f"{start}-{end}字" if end != float('inf') else f"{start}字以上" percentage = (count / len(title_lengths)) * 100 report += f"{range_text}: {count}个 ({percentage:.1f}%)\n" # 显示分析结果 self.analysis_text.delete(1.0, tk.END) self.analysis_text.insert(tk.END, report) except Exception as e: messagebox.showerror("错误", f"分析失败: {str(e)}") def analyze_keywords(self): """分析标题中的高频词汇""" if not self.collected_data: messagebox.showwarning("警告", "没有可分析的数据!") return try: # 合并所有标题文本 all_titles = ' '.join(data['title'] for data in self.collected_data) # 设置停用词 stop_words = { '的', '了', '是', '在', '我', '有', '和', '就', '都', '而', '及', '与', '着', '或', '等', '为', '一个', '没有', '这个', '那个', '但是', '而且', '只是', '不过', '这样', '一样', '一直', '一些', '这', '那', '也', '你', '我们', '他们', '它们', '把', '被', '让', '向', '往', '但', '去', '又', '能', '好', '给', '到', '看', '想', '要', '会', '多', '能', '这些', '那些', '什么', '怎么', '如何', '为什么', '可以', '因为', '所以', '应该', '可能', '应该' } # 使用jieba进行分词 words = [] for word in jieba.cut(all_titles): if len(word) > 1 and word not in stop_words: # 过滤单字词和停用词 words.append(word) # 统计词频 word_counts = Counter(words) # 生成报告 report = "===== 高频词汇分析报告 =====\n\n" report += f"总标题数: {len(self.collected_data)}\n" report += f"总词汇量: {len(words)}\n" report += f"不同词汇数: {len(word_counts)}\n\n" # 显示高频词汇(TOP 100) report += "高频词汇 TOP 100:\n" report += "-" * 40 + "\n" report += "排名\t词汇\t\t出现次数\t频率\n" report += "-" * 40 + "\n" for rank, (word, count) in enumerate(word_counts.most_common(100), 1): frequency = (count / len(words)) * 100 report += f"{rank}\t{word}\t\t{count}\t\t{frequency:.2f}%\n" # 显示分析结果 self.analysis_text.delete(1.0, tk.END) self.analysis_text.insert(tk.END, report) except Exception as e: print(f"高频词汇分析错误: {str(e)}") messagebox.showerror("错误", f"分析失败: {str(e)}") def treeview_sort_column(self, tree, col, reverse): """列排序函数""" # 获取所有项目 l = [(tree.set(k, col), k) for k in tree.get_children('')] try: # 尝试将数值型数据转换为数字进行排序 if col in ['序号', '获赞数', '粉丝数', '点赞数']: # 处理带"万"的数字 def convert_number(x): try: if '万' in x[0]: return float(x[0].replace('万', '')) * 10000 return float(x[0]) except ValueError: return 0 l.sort(key=convert_number, reverse=reverse) else: # 字符串排序 l.sort(reverse=reverse) except Exception as e: print(f"排序错误: {str(e)}") # 如果转换失败,按字符串排序 l.sort(reverse=reverse) # 重新排列项目 for index, (val, k) in enumerate(l): tree.move(k, '', index) # 更新序号 tree.set(k, '序号', str(index + 1)) # 切换排序方向 tree.heading(col, command=lambda: self.treeview_sort_column(tree, col, not reverse)) def create_help_tab(self): """创建帮助标签页""" help_frame = ttk.Frame(self.notebook) self.notebook.add(help_frame, text='使用帮助') # 创建帮助文本框 help_text = tk.Text(help_frame, wrap=tk.WORD, padx=10, pady=10) help_text.pack(fill='both', expand=True) # 添加滚动条 scrollbar = ttk.Scrollbar(help_frame, orient='vertical', command=help_text.yview) scrollbar.pack(side='right', fill='y') help_text.configure(yscrollcommand=scrollbar.set) # 帮助内容 help_content = """ 抖音作品分析工具使用指南 ==================== 1. 数据采集 ----------------- • 支持两种采集方式: - 直接输入抖音链接 - 关键词搜索采集 • 关键词搜索支持以下类型: - 视频搜索 - 用户搜索 - 音乐搜索 - 话题搜索 • 采集参数说明: - 滚动次数:决定采集数据量的多少 - 延迟(秒):每次滚动的等待时间,建议2-3秒 • 使用技巧: - 采集时可随时点击"停止采集" - 建议设置适当的延迟避免被限制 - 数据采集过程中请勿关闭浏览器窗口 2. 数据查看 ----------------- • 视频数据: - 包含标题、作者、发布时间等信息 - 双击可直接打开视频链接 - 支持按列排序 - 可导出为Excel或JSON格式 • 用户数据: - 显示用户名、抖音号、粉丝数等信息 - 双击可打开用户主页 - 支持数据排序 - 可单独导出用户数据 3. 数据分析 ----------------- • 互动数据分析: - 统计总点赞数、平均点赞等指标 - 展示互动数据分布情况 • 内容长度分析: - 分析标题长度分布 - 显示最长/最短标题统计 • 高频词汇分析: - 提取标题中的关键词 - 展示TOP100高频词汇 - 计算词频占比 4. 常见问题 ----------------- Q: 为什么采集速度较慢? A: 为了避免被反爬虫机制拦截,程序设置了延迟机制。 Q: 如何提高采集成功率? A: 建议: - 设置适当的延迟时间(2-3秒) - 避免过于频繁的采集 - 确保网络连接稳定 Q: 数据导出格式说明? A: 支持两种格式: - Excel格式:适合数据分析和处理 - JSON格式:适合数据备份和程序读取 Q: 如何处理采集失败? A: 可以: - 检查网络连接 - 增加延迟时间 - 减少单次采集数量 - 更换搜索关键词 5. 注意事项 ----------------- • 合理使用: - 遵守抖音平台规则 - 避免频繁、大量采集 - 合理设置采集参数 • 数据安全: - 及时导出重要数据 - 定期备份采集结果 • 使用建议: - 建议使用稳定的网络连接 - 采集时避免其他浏览器操作 - 定期清理浏览器缓存 如需更多帮助,请参考项目文档或联系开发者。 """ # 插入帮助内容 help_text.insert('1.0', help_content) help_text.config(state='disabled') # 设置为只读 if __name__ == "__main__": root = tk.Tk() app = DouyinAnalyzer(root) root.mainloop() #您下载的资源来自www.fulicode.cn三、下载指南 123云盘下载 抖音数据采集分析工具.zip 下载地址:https://www.123684.com/s/rCKrjv-Vpb8d? 提取码:vq7x无论你是经验丰富的专业开发者,能够熟练地对代码进行二次开发与定制;还是对抖音数据满怀热忱、刚刚踏入数据领域的爱好者,渴望通过数据了解抖音世界的奥秘,都能毫无门槛地获取这份宝贵的资源。我们衷心希望这款工具能够在你的创作与分析旅程中发挥重要作用,帮助你在抖音平台的创作之路上更加得心应手,在市场分析领域取得更优异的成果,开启属于自己的数据洞察新征程。